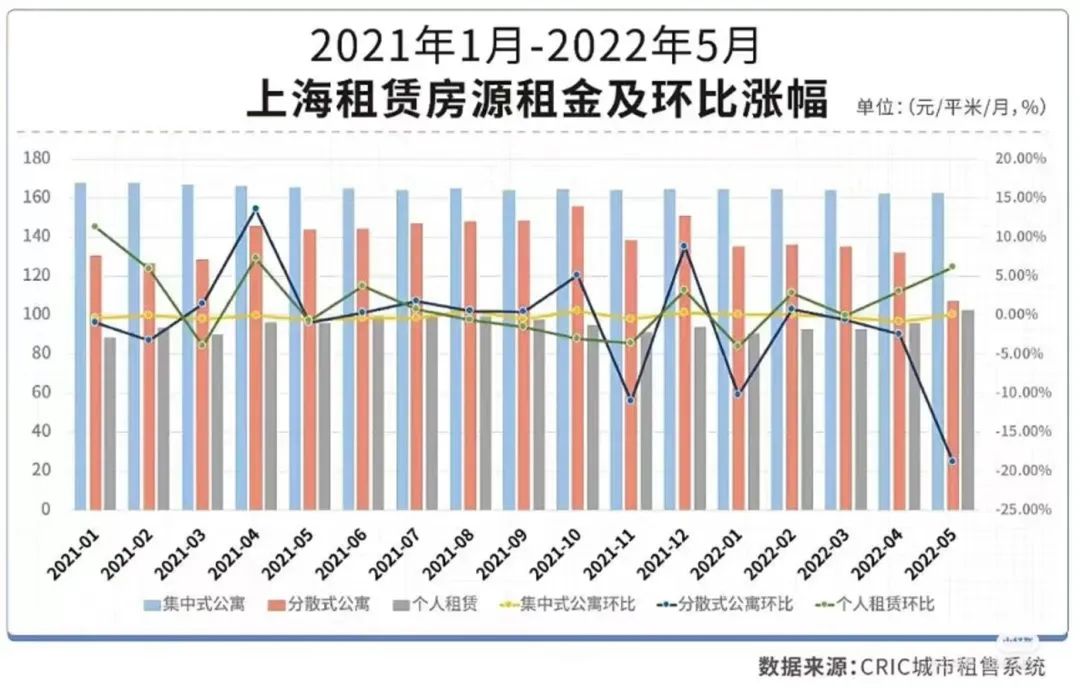

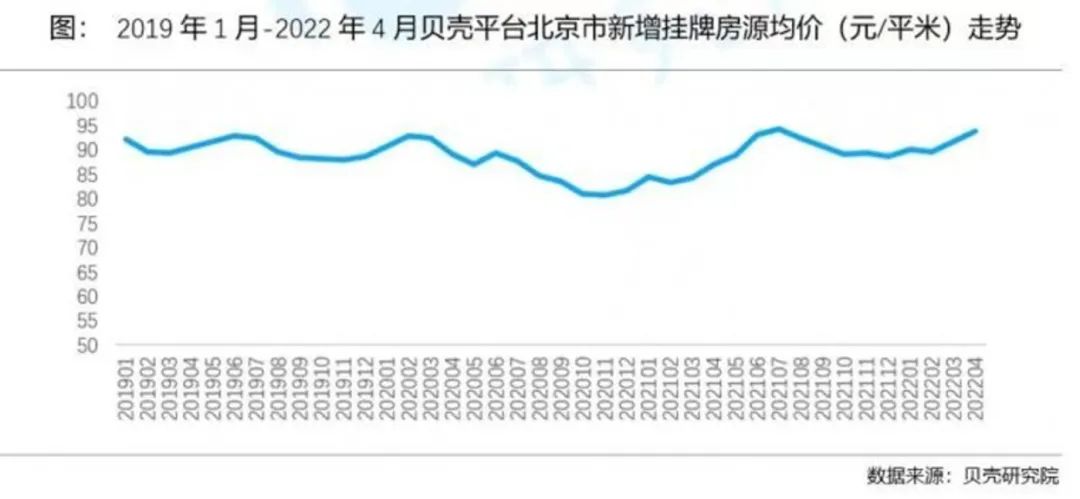

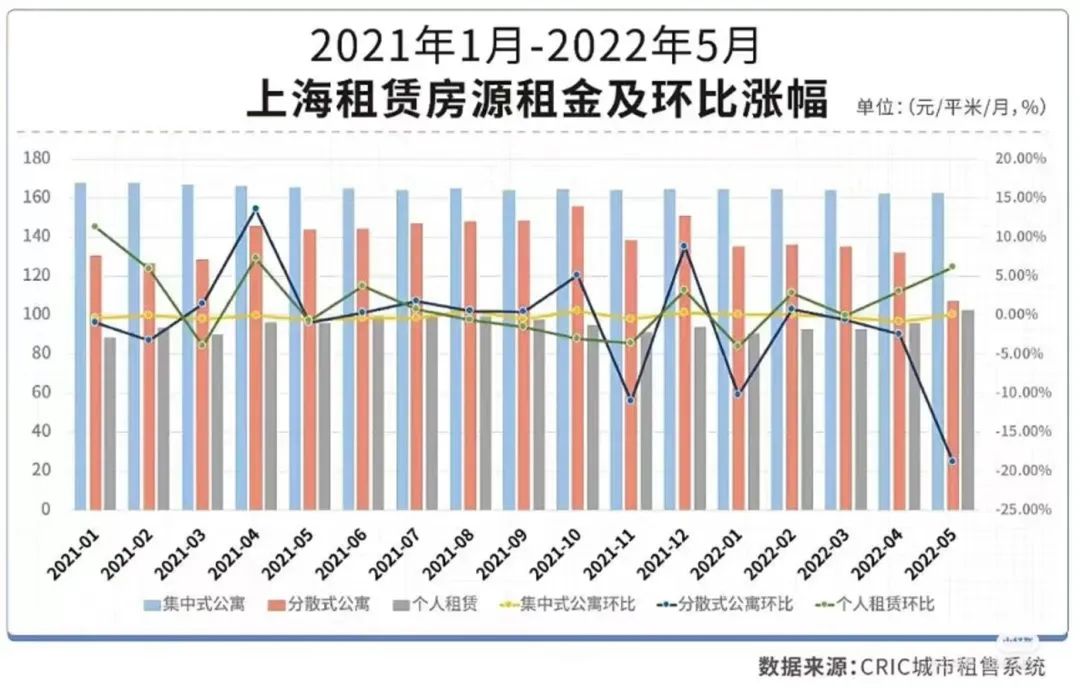

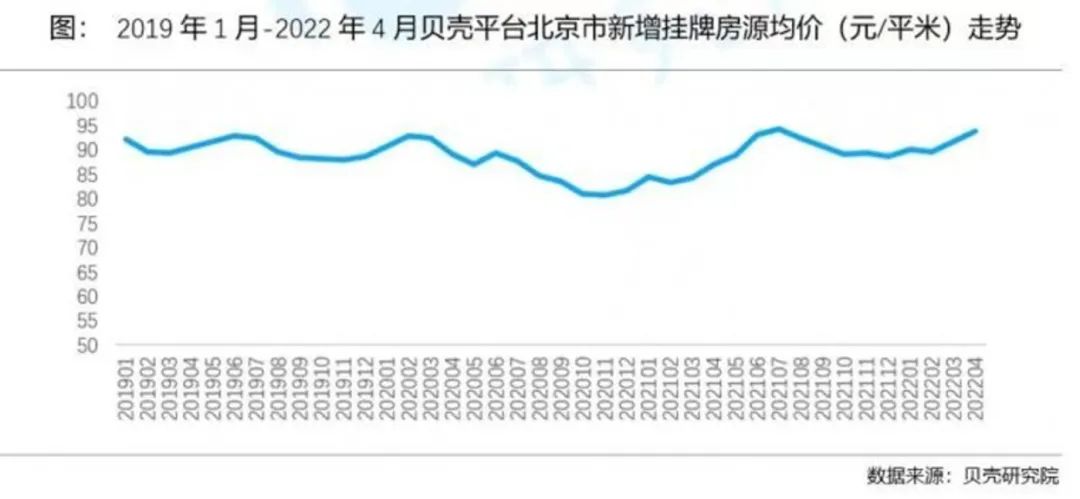

▎上海、北京两地的长租市场,到底呈现出怎样一种境况?长租市场恢复元气了吗?

钛媒体编辑丨柳牧宗

上海房租普遍上涨,北京「冷热分化」

房租上涨何时休?

租赁行业下半场如何破局?

转自:https://mp.weixin.qq.com/s/5aeeV6dFjpC9ckUCGuImtA

分享个人经验,保留阅读记录,做时间的朋友

钛媒体编辑丨柳牧宗

转自:https://mp.weixin.qq.com/s/5aeeV6dFjpC9ckUCGuImtA

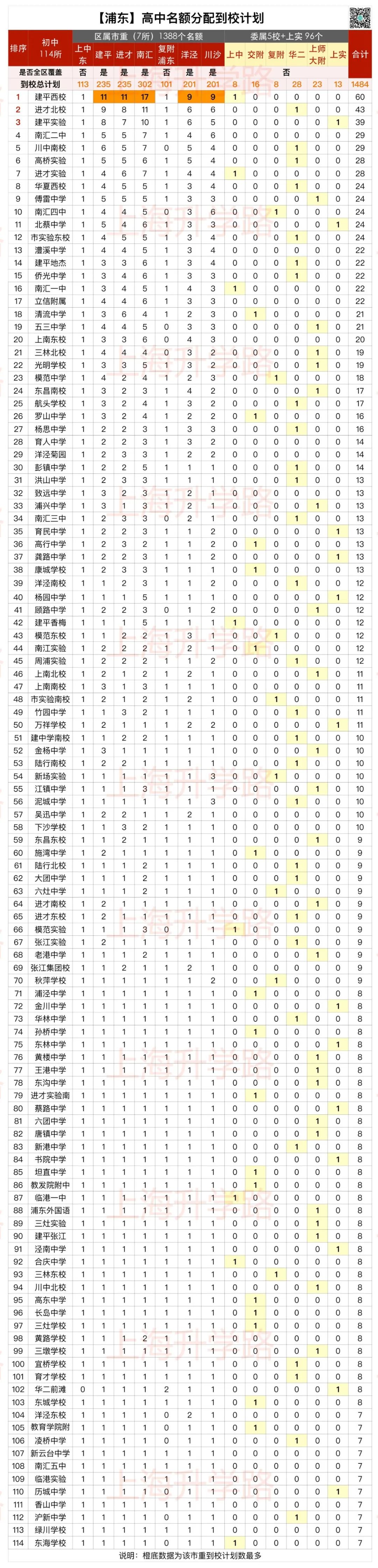

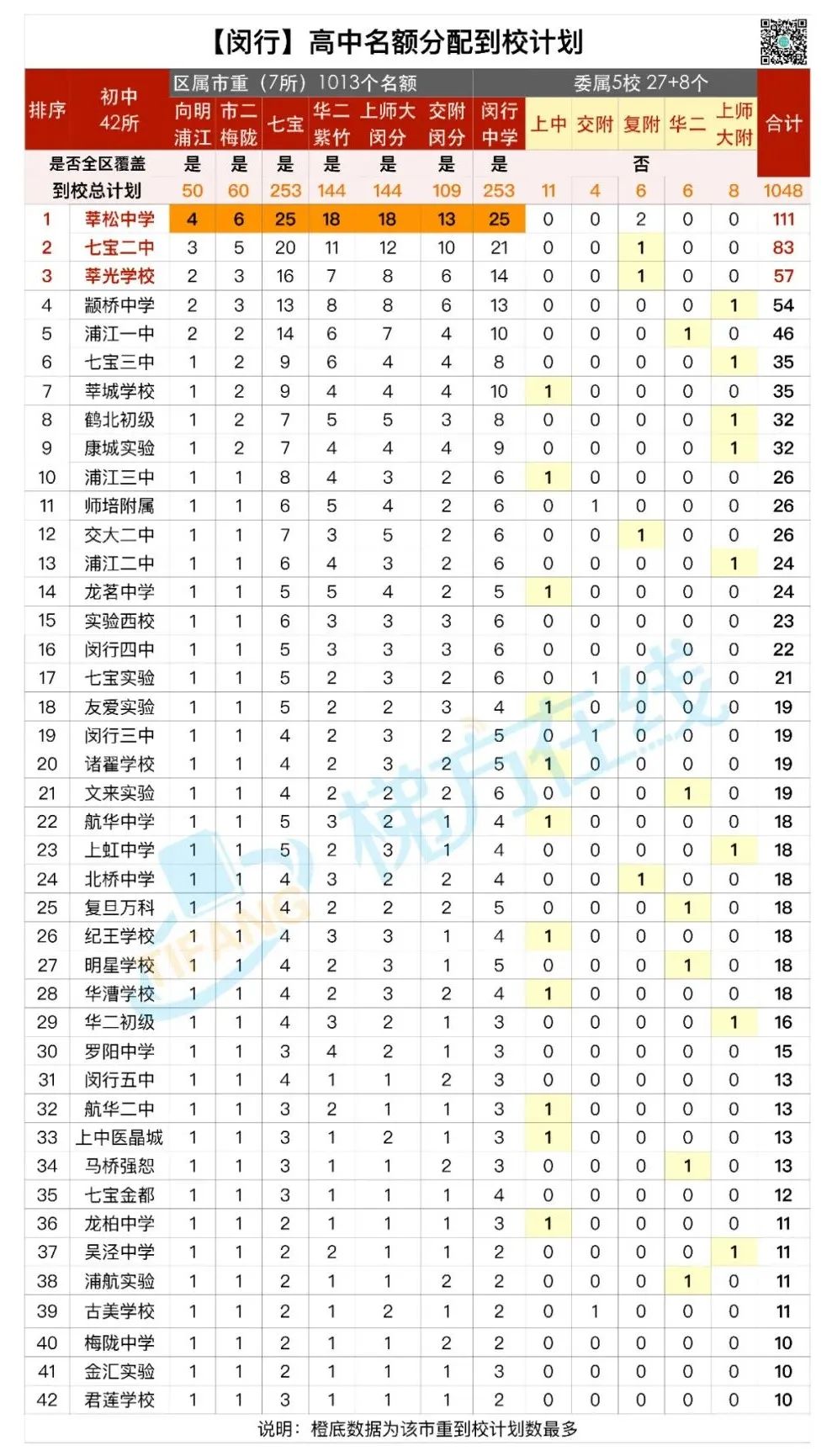

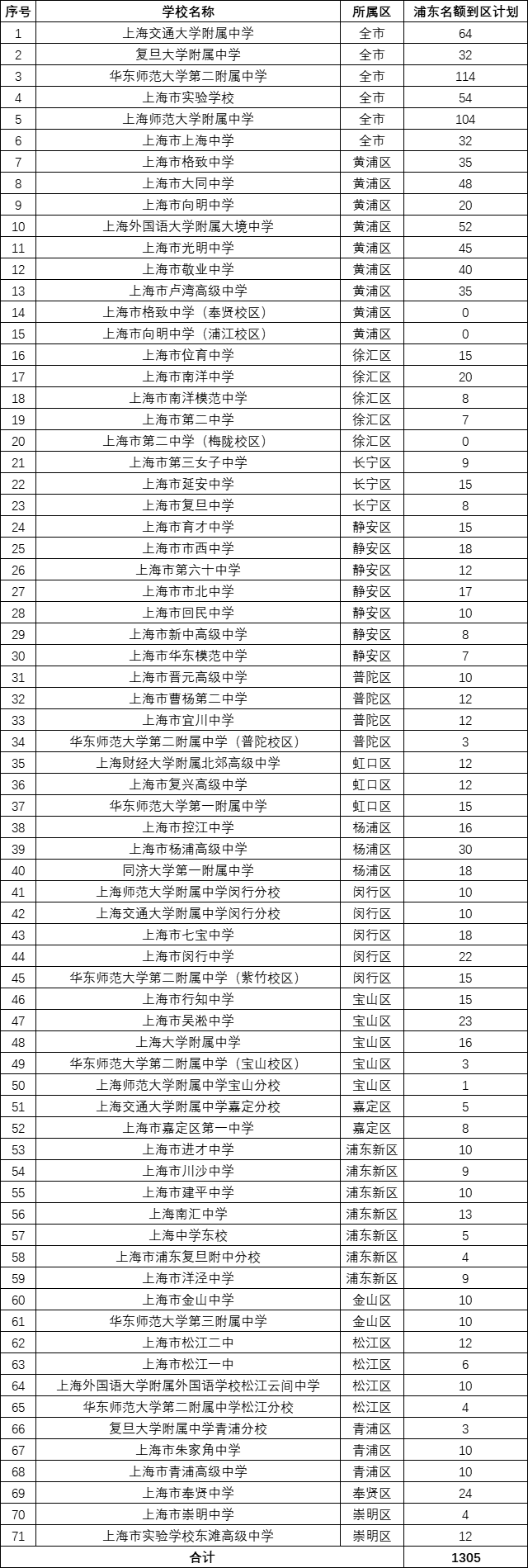

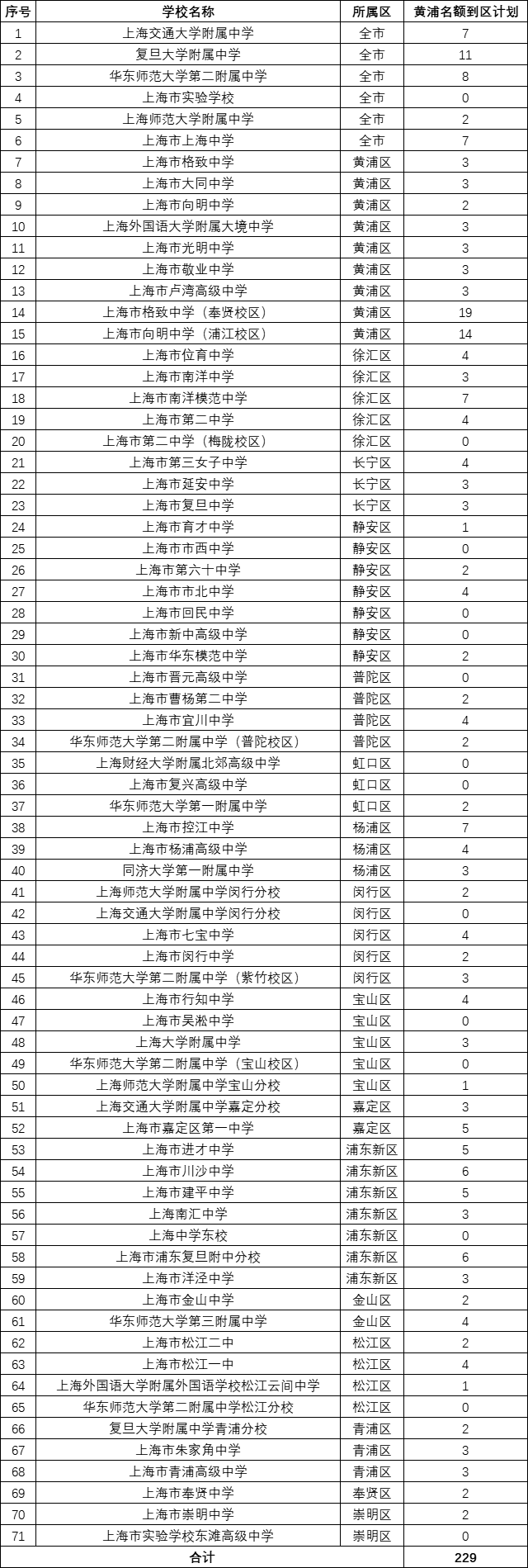

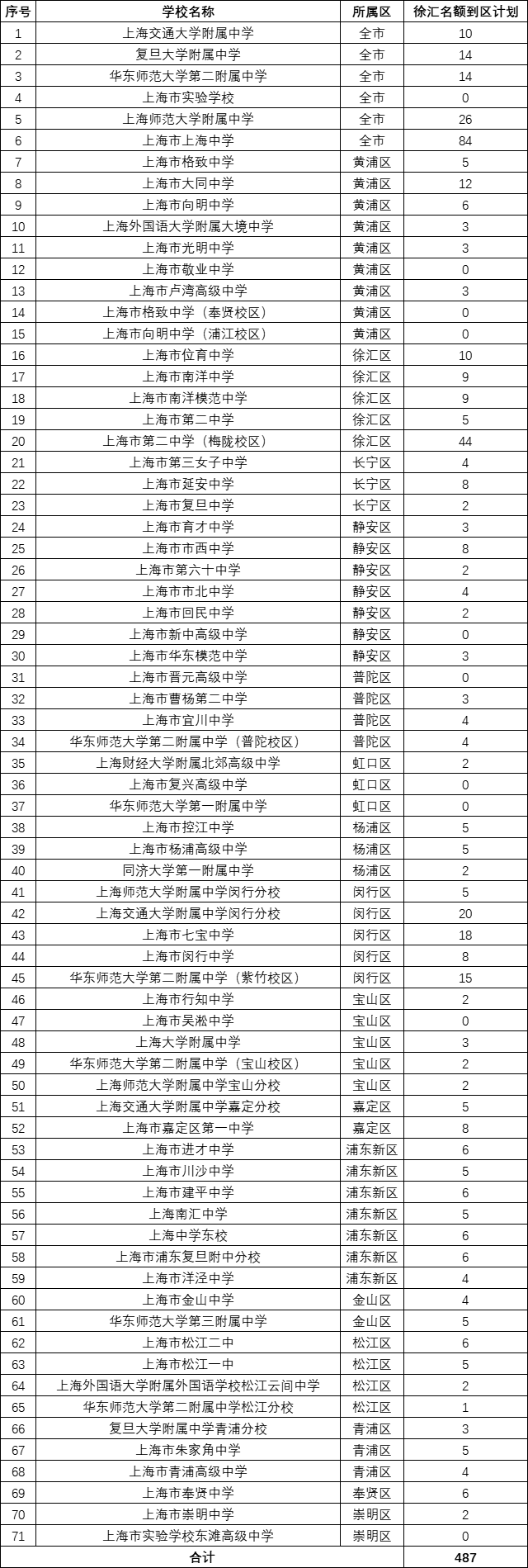

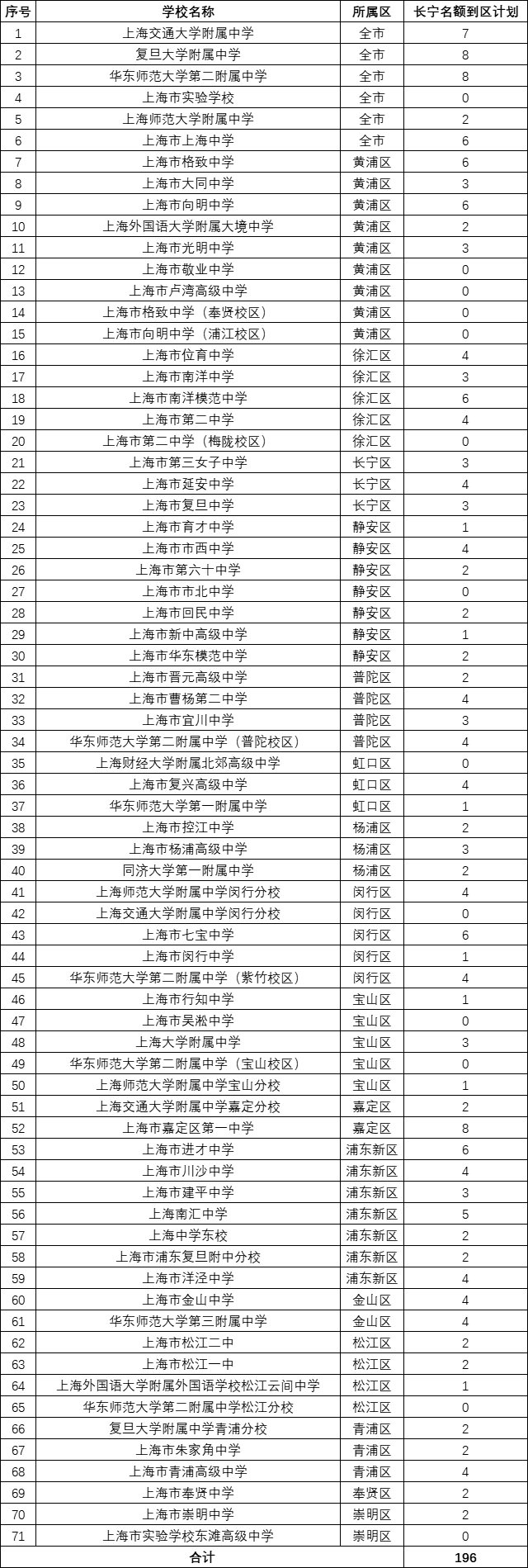

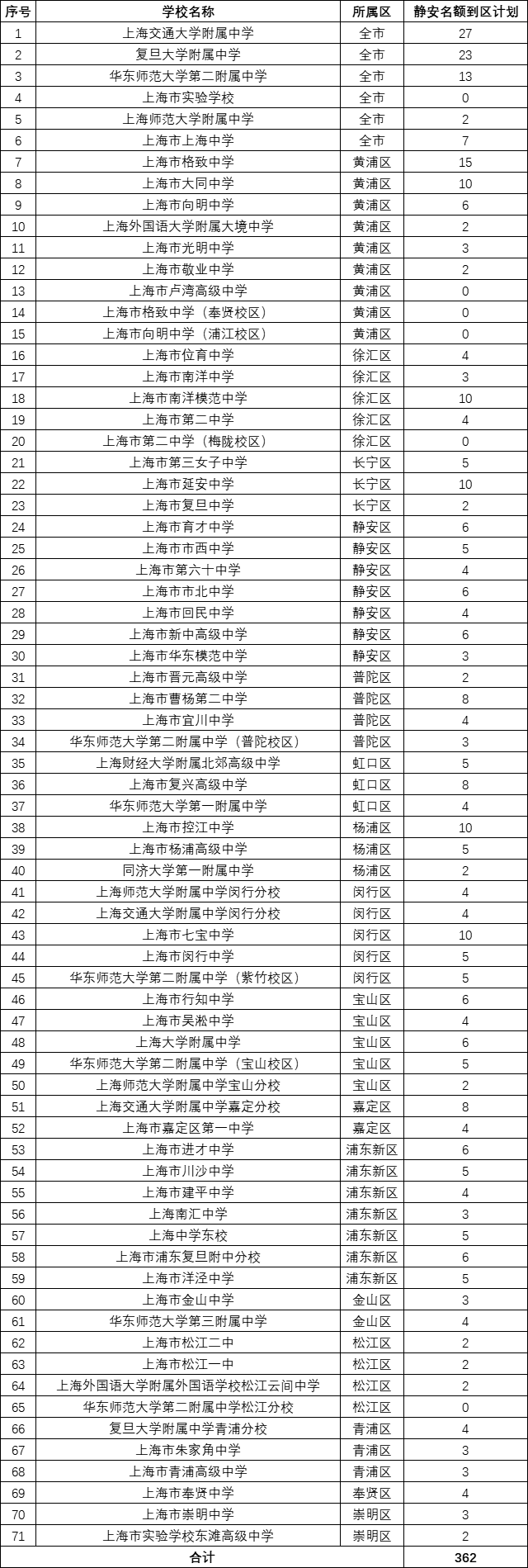

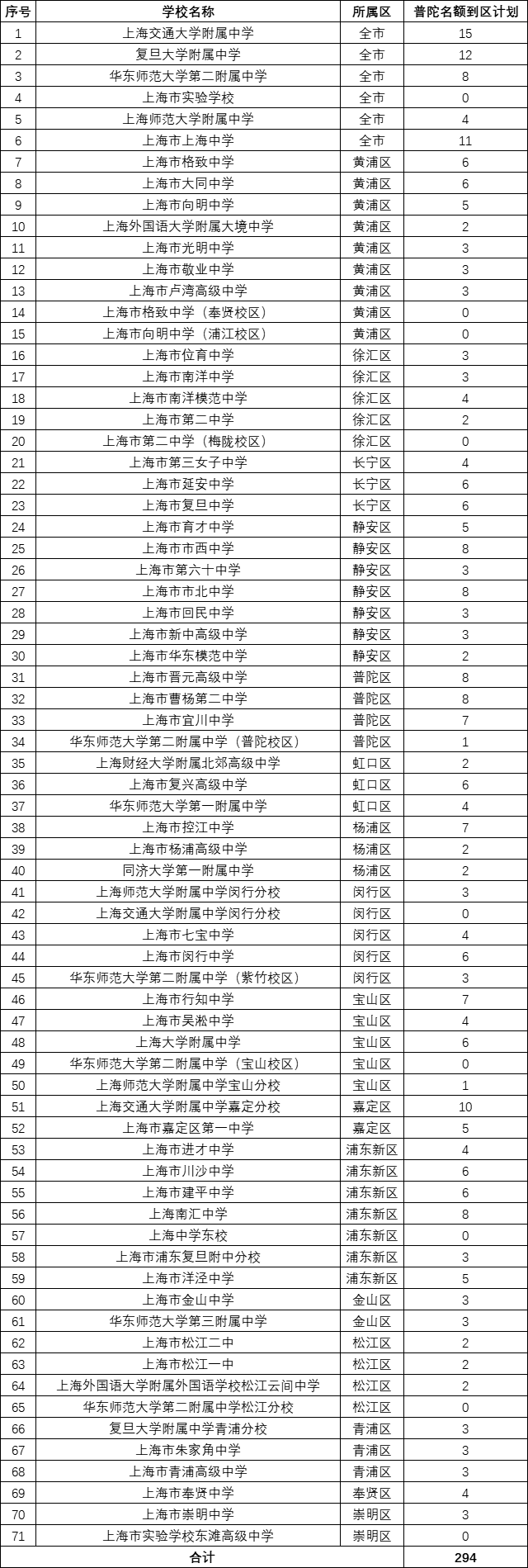

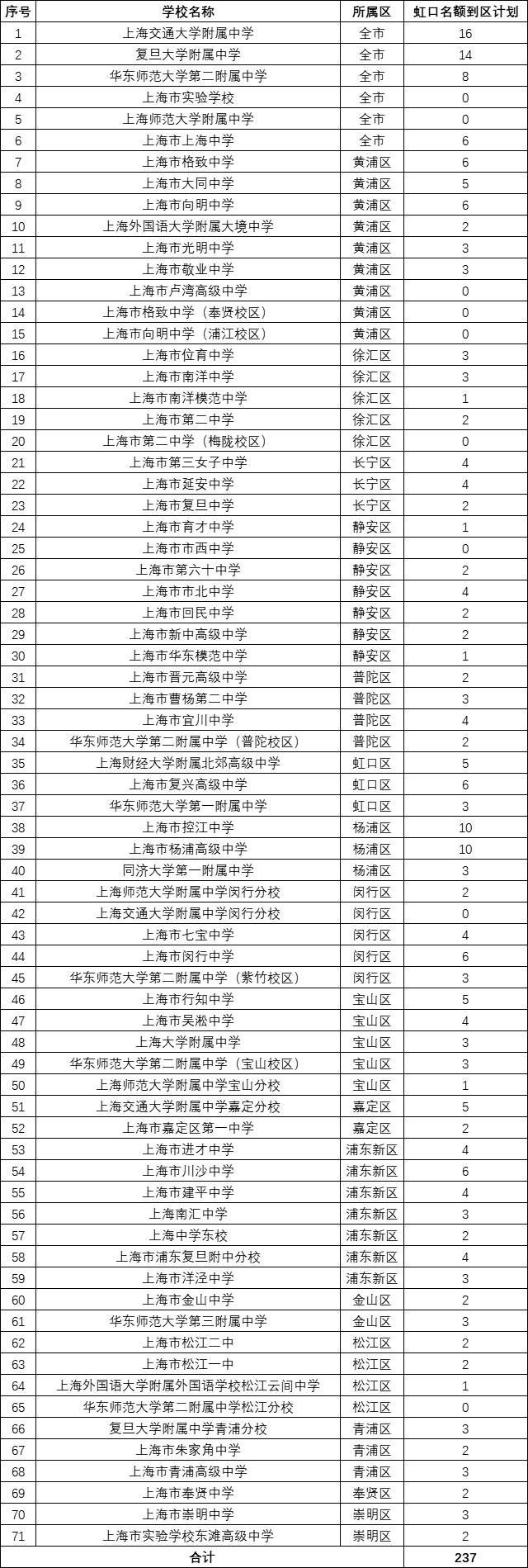

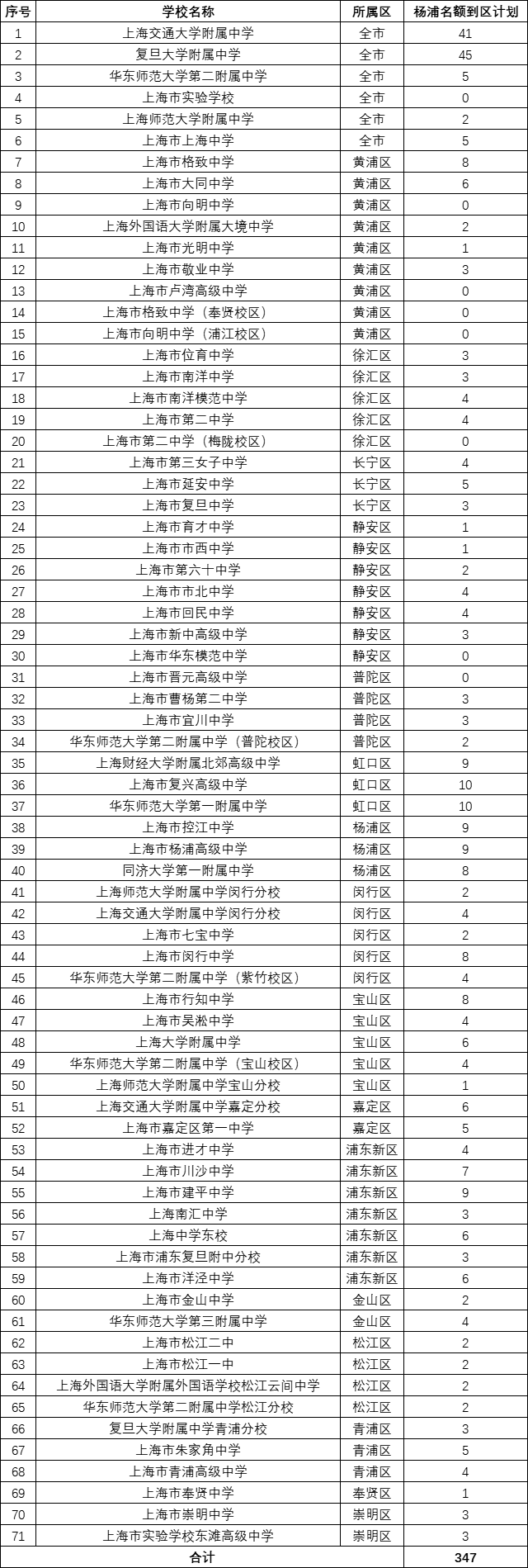

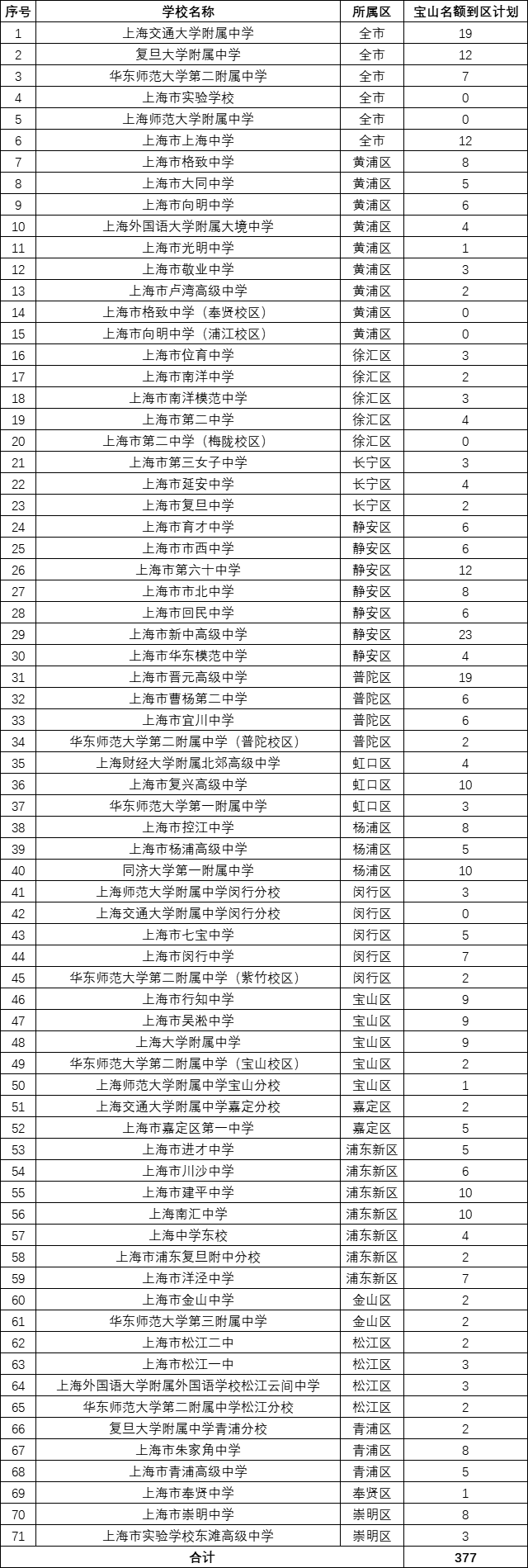

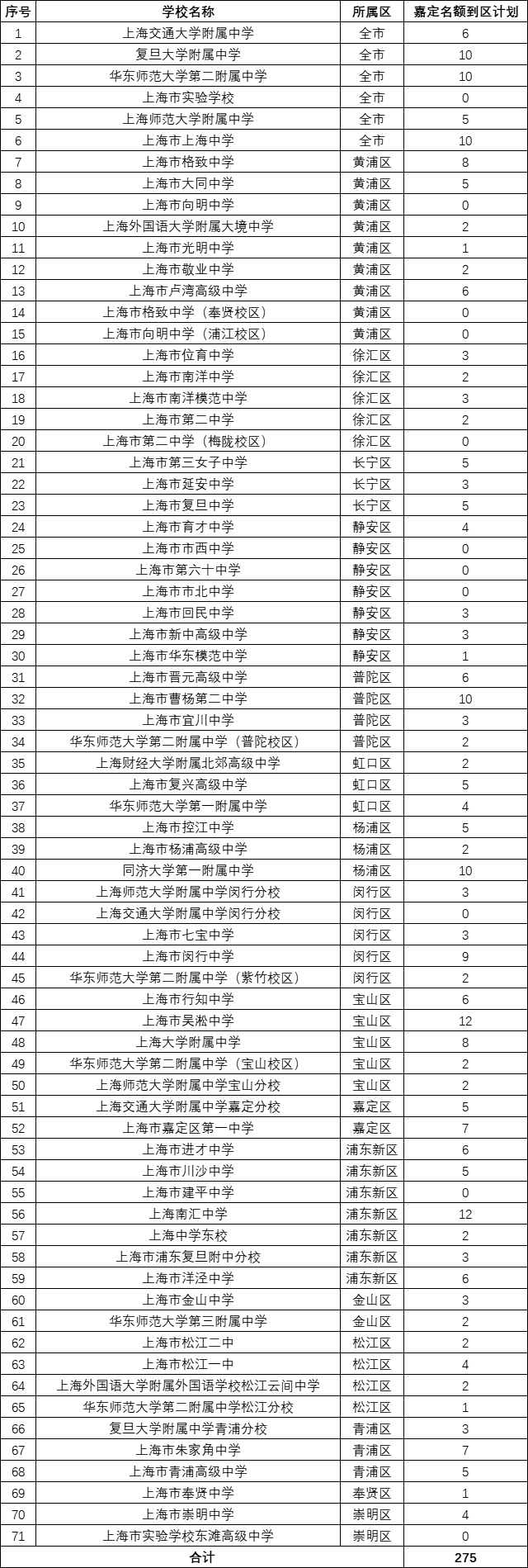

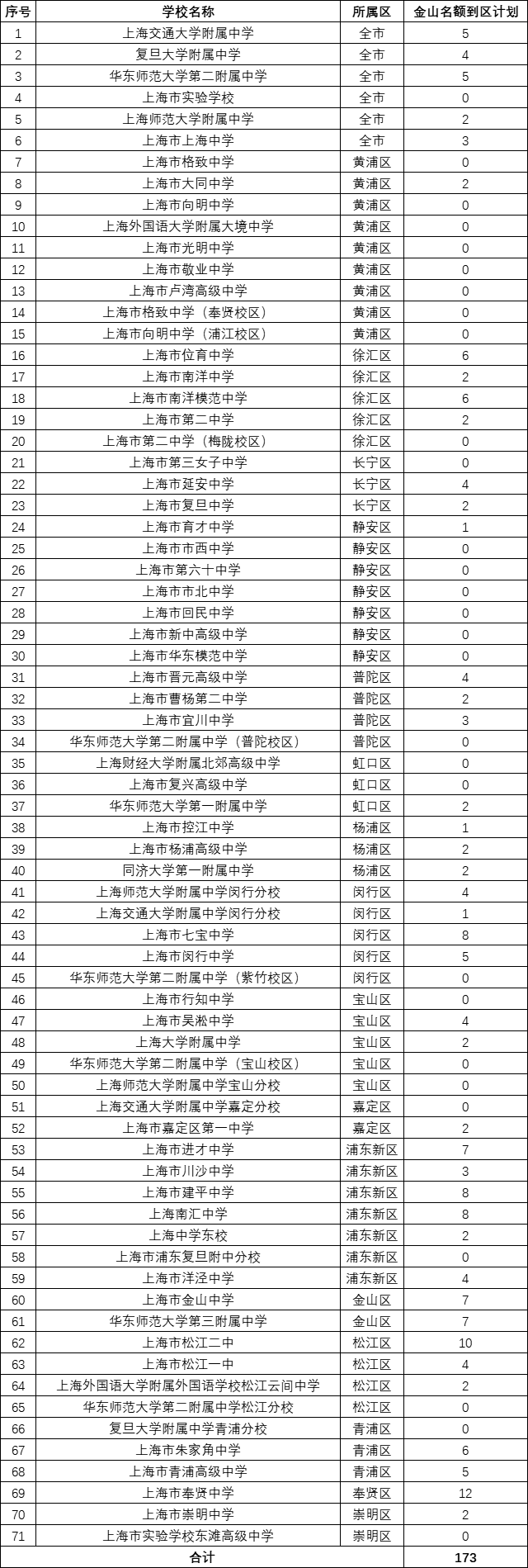

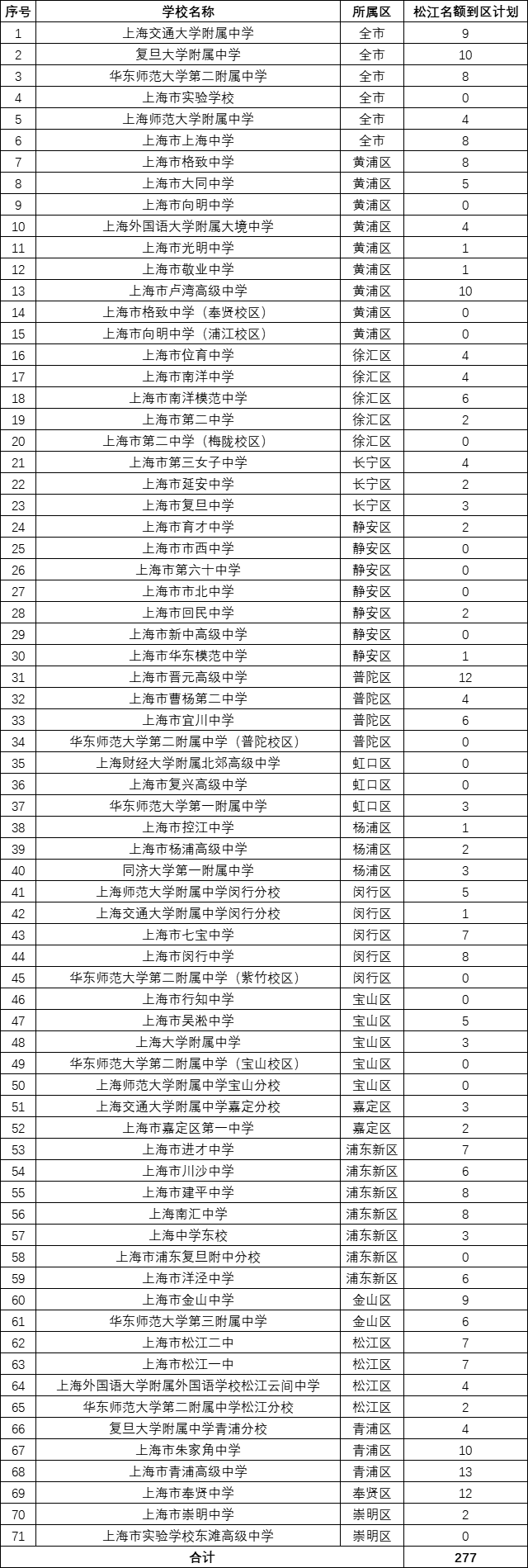

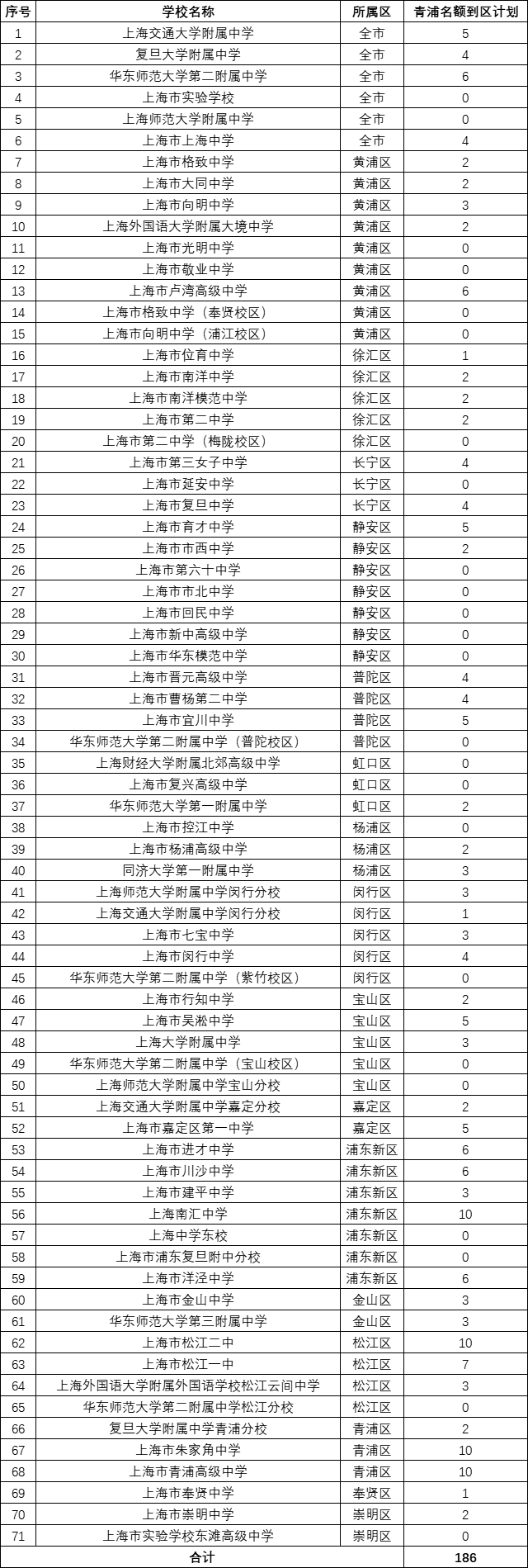

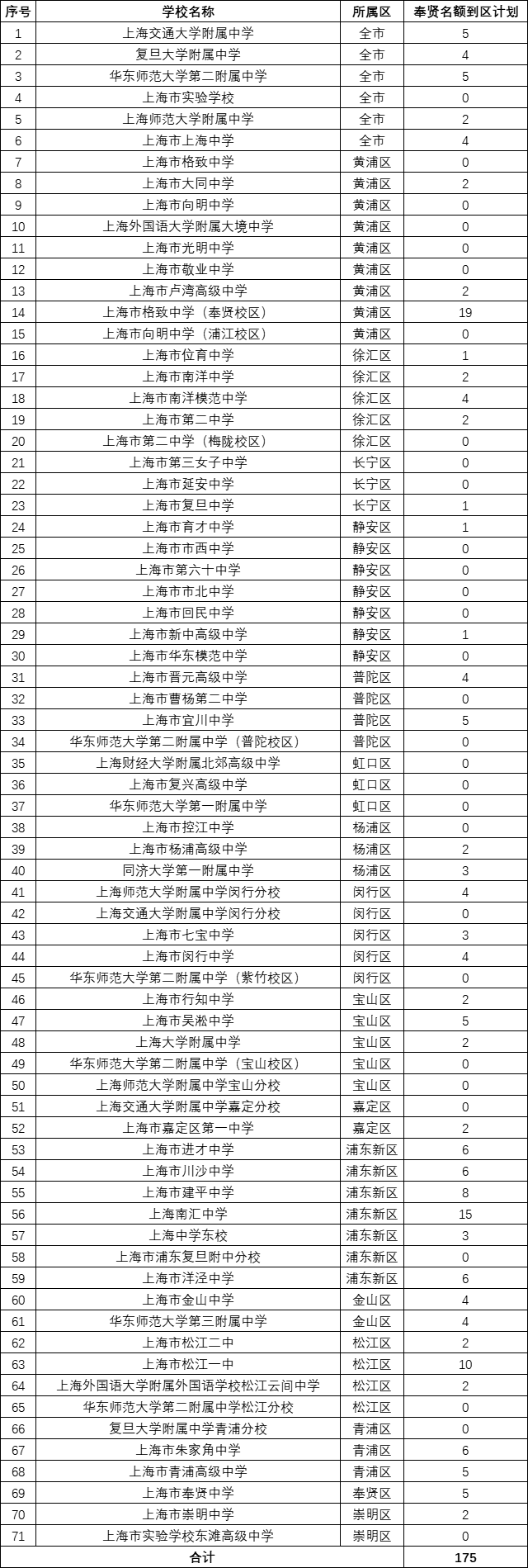

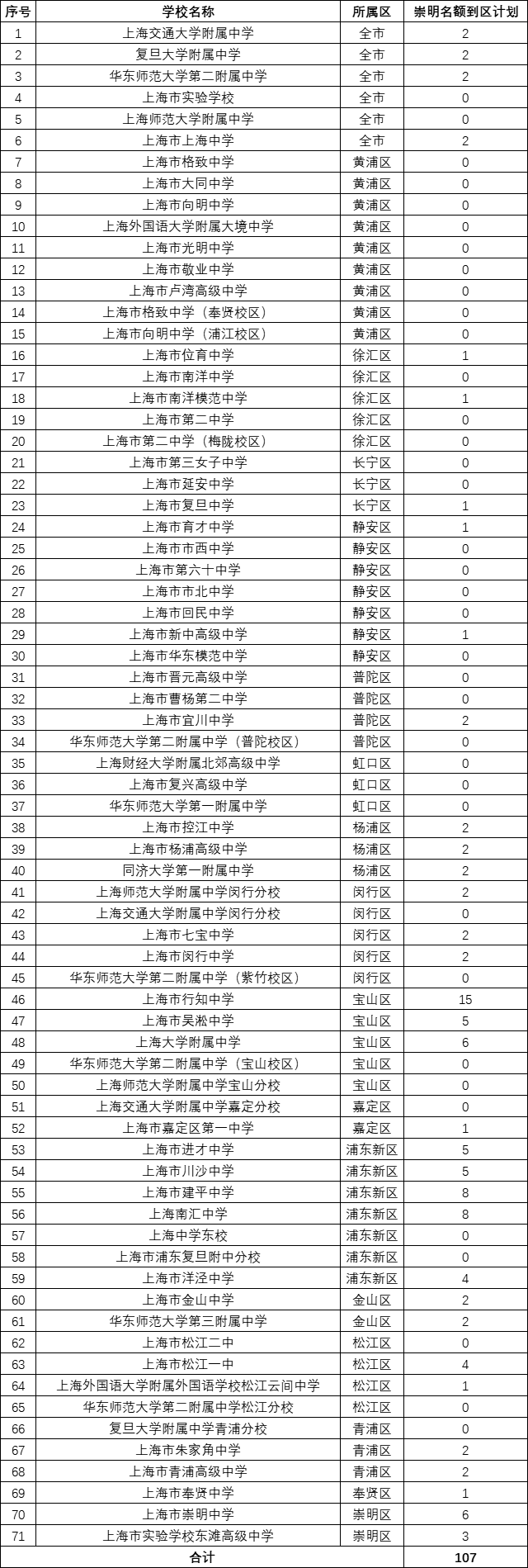

名额分配到校计划总表

1、名额分配到校计划总计:9995个,其中:

四校:241个

上师大附中+上实验:60个

四分:842个

八大+分校:1786个

2、获得计划数最多Top3:

浦东

闵行

黄浦

3、获得四校计划数最多Top3:

浦东

闵行

杨浦

4、名额分配到区计划占比Top3:

黄浦

长宁

普陀

16区运气王大PK

名额分配到校含金量

1、名额分配到校含金量Top5:

嘉定

闵行

浦东

青浦

普陀

名额分配到校计划

名额分配到校:

稍后更新在文末“阅读原文”中

不选择生源学校名单:

名额分配到区:

名额分配到校:

名额分配到区:

名额分配到校:

名额分配到区:

名额分配到校:

名额分配到区:

名额分配到校:

名额分配到区:

名额分配到校:

名额分配到区:

名额分配到校:

名额分配到区:

名额分配到校:

名额分配到区:

名额分配到校:

名额分配到区:

名额分配到校:

名额分配到区:

名额分配到校:

名额分配到区:

名额分配到校:

名额分配到区:

名额分配到校:

名额分配到区:

名额分配到校:

名额分配到区:

名额分配到校:

稍后更新在文末“阅读原文”中

名额分配到区:

名额分配到校:

https://mp.weixin.qq.com/s/eKzd5LFbYtx2ePAI_k-PPw

名额分配到区:

转自:https://mp.weixin.qq.com/s/kDP4QYYJKne6ZTUTZ84WtQ

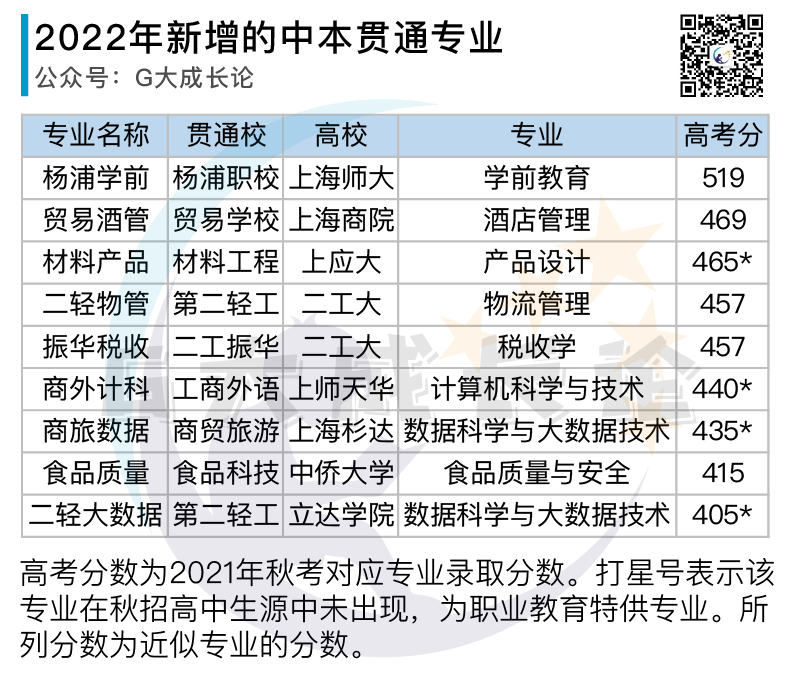

昨天上海教育考试院宣布了2022年中本贯通专业招生计划。

和去年相比,招生专业从61个微降到60个,招生人数从1850人微增至1870人。

看似平稳的背后,是中本贯通翻天覆地的变化。

G大看了今年的招生专业列表后不禁感叹:从某种意义上讲,我们所熟悉的那个“中本贯通”已经离我们远去。

当下的这个中本贯通,就像一个勉力支撑起一个大架子的孩童,在苦心等待未来。

这个大架子,叫职业本科贯通教育试点。

要解释这种感受,我们要从2020年中本贯通分数线Top11的专业,及其现状讲起:

如上图,2020年分数最高的11个中本贯通专业,其中有8个已经不复存在。

电力的两个拳头专业、健医卫校的两个护理专业、公用事业的轨道通号、群益的学前教育。从2015年开始试点到现在的漫长岁月里,上述专业几乎已经成为了中本贯通的代表作品。

而他们,在2022年,将全部离场。

看到这里,我想你应该明白G大本文开场的那段陈述。

我曾经在一篇分析中本贯通的文章里谈到健医卫校 – 中医大学的护理项目时讲:总有一天我们会怀念读中职校可以直升双一流大学本科的日子。

没想到这一天来得这么快。

以下是2022年取消的中本贯通专业全列表。

总计11个,比前几天G大在分析上师学前专业文章里面预估的会取消5-10个专业的上限还多一个。R.I.P

如各位所见,取消的专业大部分属于中本贯通里的高分专业。这必将对2022年的中本贯通录取分数线形成压力。

这件事情我们在2021年电力取消两个拳头专业以后,导致一个就业其实不算太好的新专业「信息安全」送上了各专业分数线榜首,就可见一斑。

2022年共计有9个新增专业,列表如下:

最闪耀的是我们前几天已经聊过的上师大学前教育专业。这个专业是有史以来登陆中本贯通的所有专业中对应高考分数最高的。

贸易学校和商院联合推出的酒店管理也不错。商院的酒店管理是软科A类专业,口碑一直很好。

贸易学校在前几年是商院直属学校。他的一个校区同时挂牌商院高职学院赤峰路校区。但我有读者反馈目前两校之间没有关联。

上应大的这个产品设计专业在高招里放在艺术类,普通批没有。本次中本贯通招生时不需要额外提前面试,零基础也可以报考。但是美术类专业就业都不容易。

其他专业就没什么亮点了。

总之很难支撑起取消的那些专业所留下的空洞。

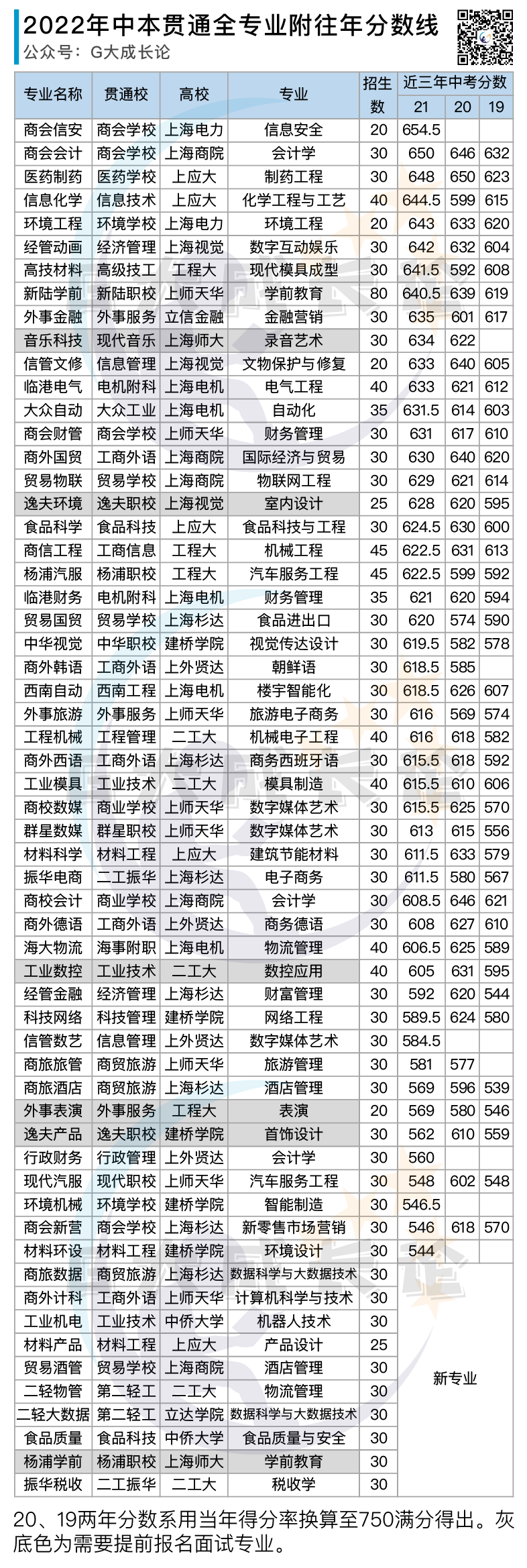

最后给一张今年招生的专业近三年录取分数表。中本贯通专业分数波动比高中要大很多,所以建议不要只看去年一年的分数线。

为了方便理解,我把20、19两年的分数线折算成了750满分。折算过程有点问题,但不影响各位用这个表来做大方向的判断。

中本贯通就写这些。

转自:https://mp.weixin.qq.com/s/uRlLf7V9cS2_ErwopX64Xg

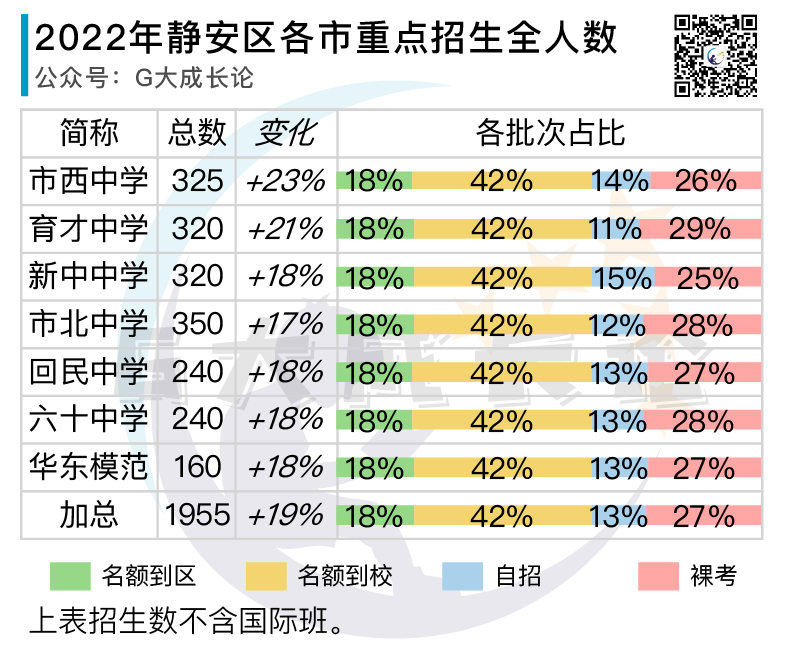

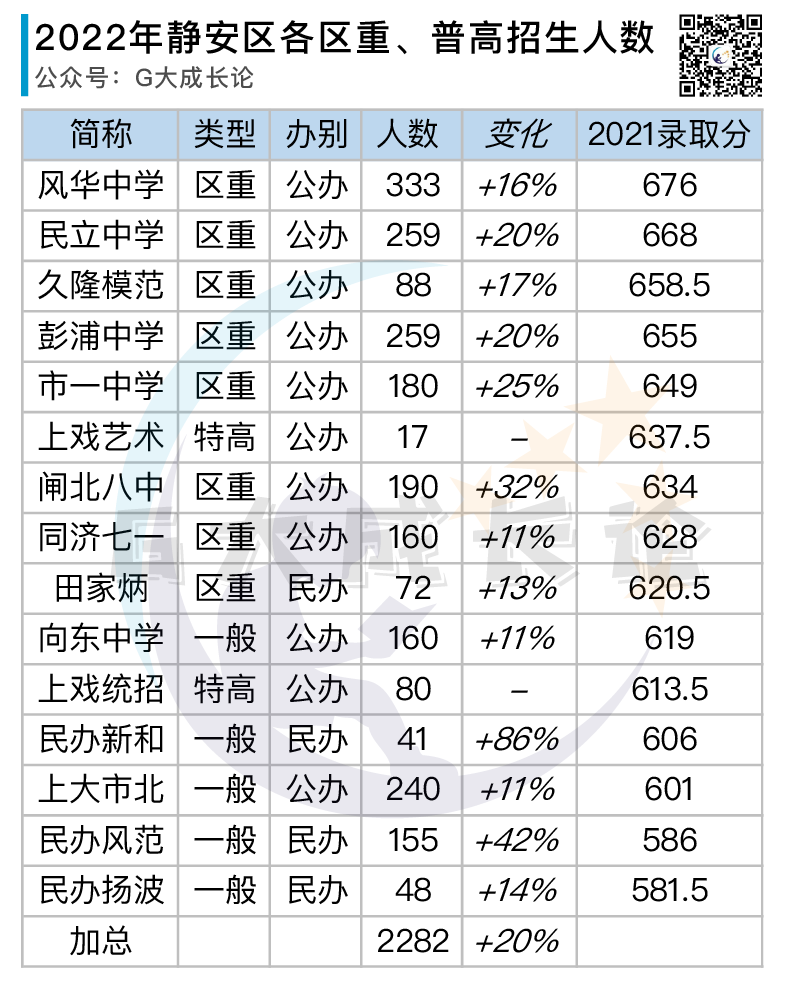

静安区教育局昨日官宣了本区各高中全渠道招生人数,并让家长开始着手准备志愿填报。

G大于是就公布的数据做一些统计整理,并结合过往数据给各位考生家长一些参考和建议。

先上各位最关心的区属市重点分析:

市重整体招生人数上涨20%,幅度不小。

名额分配的占比是60%(到区+到校),在市教委给出的50%-65%范围内偏上限。

其中到区和到校的比例是3:7,和市教委给的比例吻合。

自招(含艺体骨干生)占比13%,裸考占比27%,这些都符合我们此前的分析。

市重以下,区重和普高加起来也扩招了20%:

这些招生全部放在裸考批次(即1-15平行志愿),久隆模范需要出具贫困证明,并且在平行志愿中填报第一顺位。

和市级艺术体育骨干走自招不同,区级艺术体育骨干走的是裸考降分,名额统一计入裸考内。(顺便说下往年其实也是如此,所以艺体骨干只有市重发生了变化)

特别提下上戏附中。该校艺术类专业招生名额分配方式产生了较大变化。过往是全市统一调配名额,今年变成指定名额到各区。比如静安本区是17个名额。

该校的美术类专业本来宣称仅在静安招生,后来又改回了全市招生。

另外该校的统招批次(分数低的那个)是本区唯一招生人数没有变化的高中。

上述高中该怎么填报我们后面再聊。

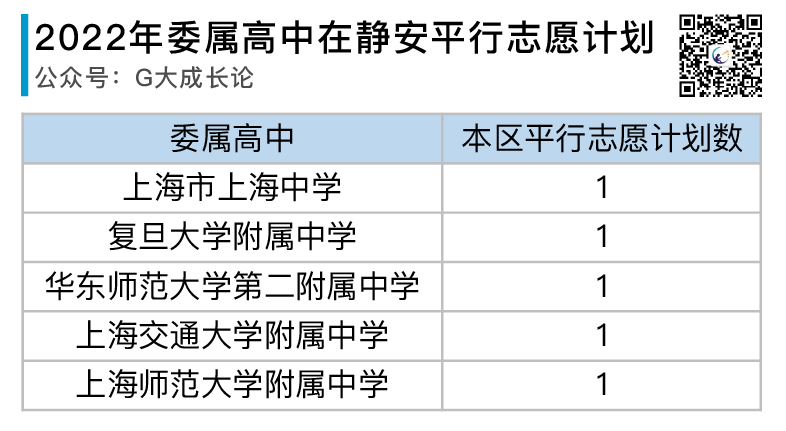

另外一个意外是委属五校按照新政的要求,在本区投放了平行志愿。

虽然数量少得很抽象,但毕竟是有了:

招生计划最后一部分是以民办高中为主的外区高中在静安招生计划。

涨幅比本区高中还要高。这反映了高中扩招并不是静安一家的特例,各区都在扩招。

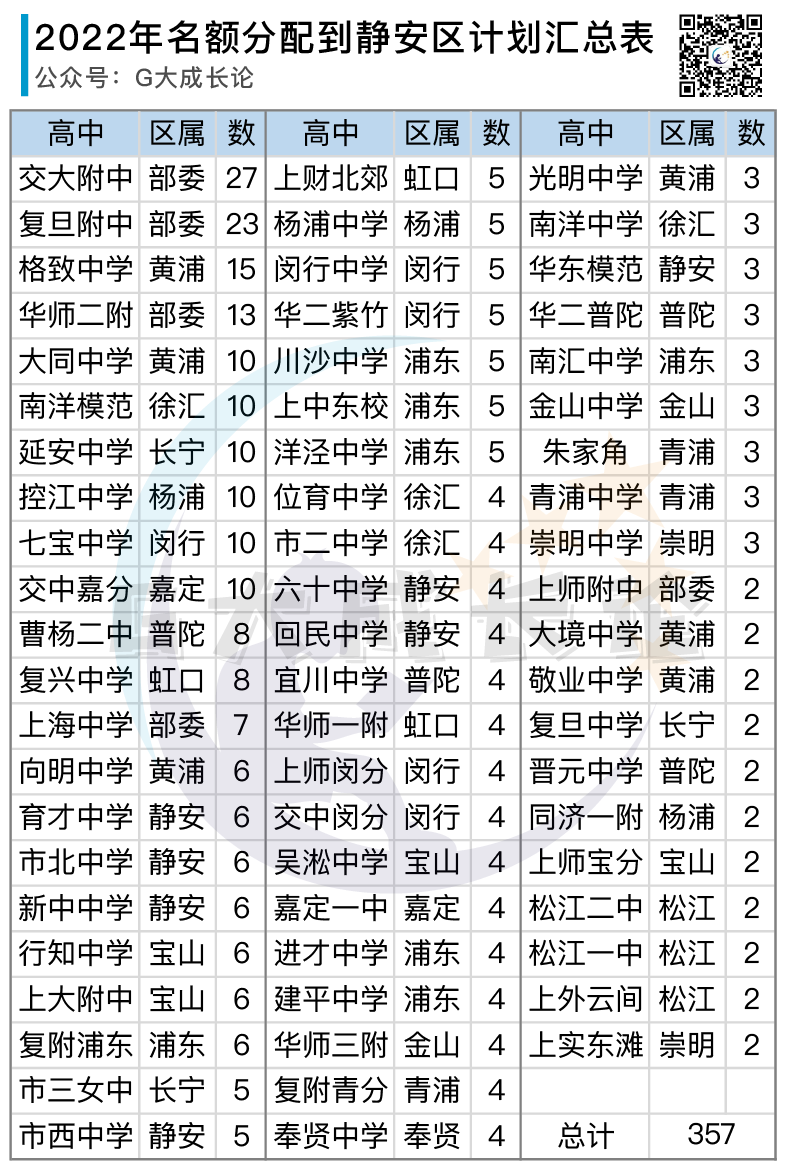

然后是两张名额分配的表:先到区

静安无八大,于是八大对静安是真爱。

然后是名额到校表:

招生情况讲完,给一些志愿填报建议。

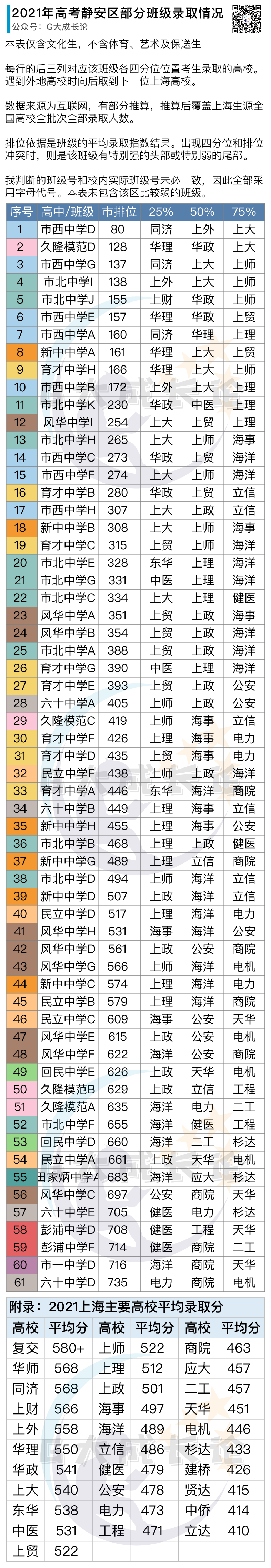

这部分简单让我先搬出两张之前发布的表格:

以及具体到班级的版本:

其实上面这两张表出来,也就不用我再解释了,你们自己按图索骥就行。

静安就写到这里。