说明:以下中考成绩收集自各初中官网官微、媒体报道及家长分享~

转自:https://mp.weixin.qq.com/s/mbKVikYnokmQacK0KmIhow

分享个人经验,保留阅读记录,做时间的朋友

说明:以下中考成绩收集自各初中官网官微、媒体报道及家长分享~

转自:https://mp.weixin.qq.com/s/mbKVikYnokmQacK0KmIhow

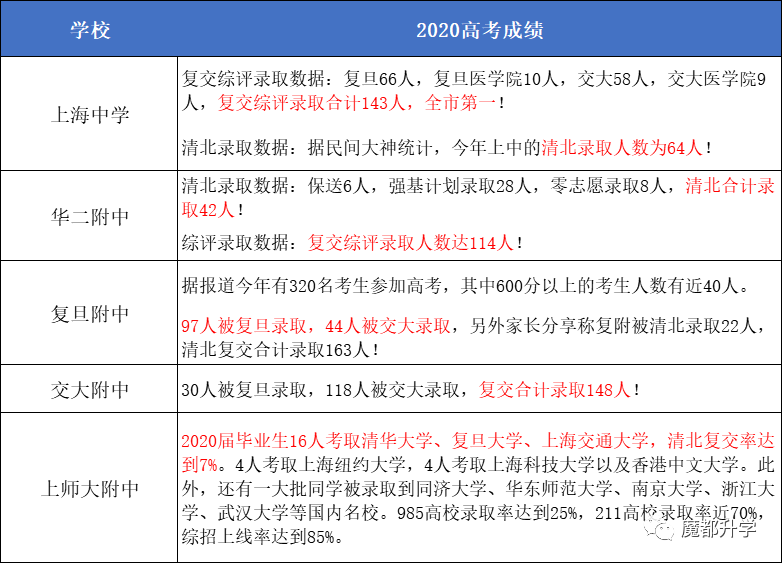

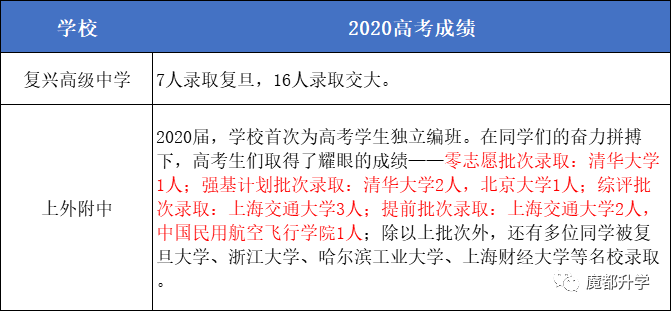

市委属高中

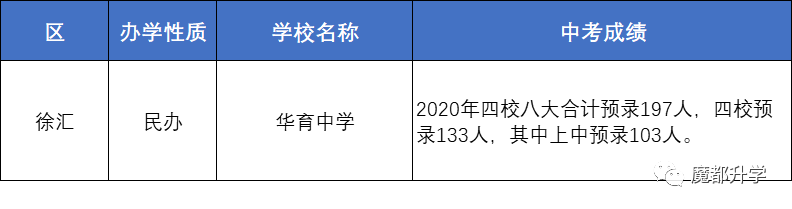

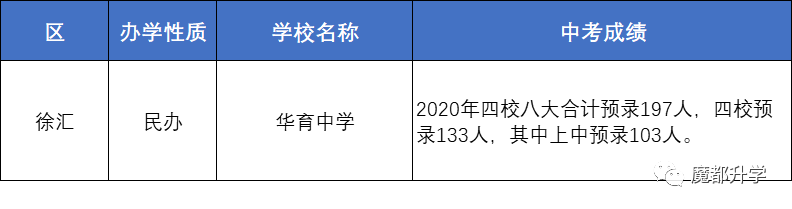

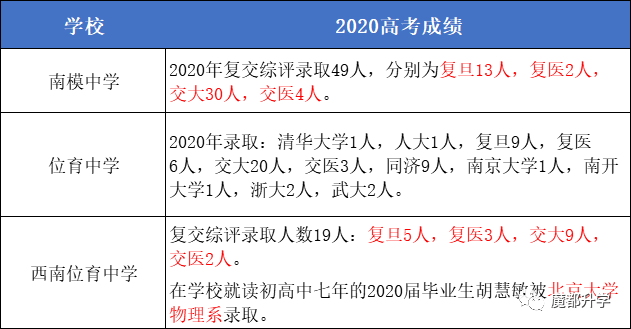

徐汇区

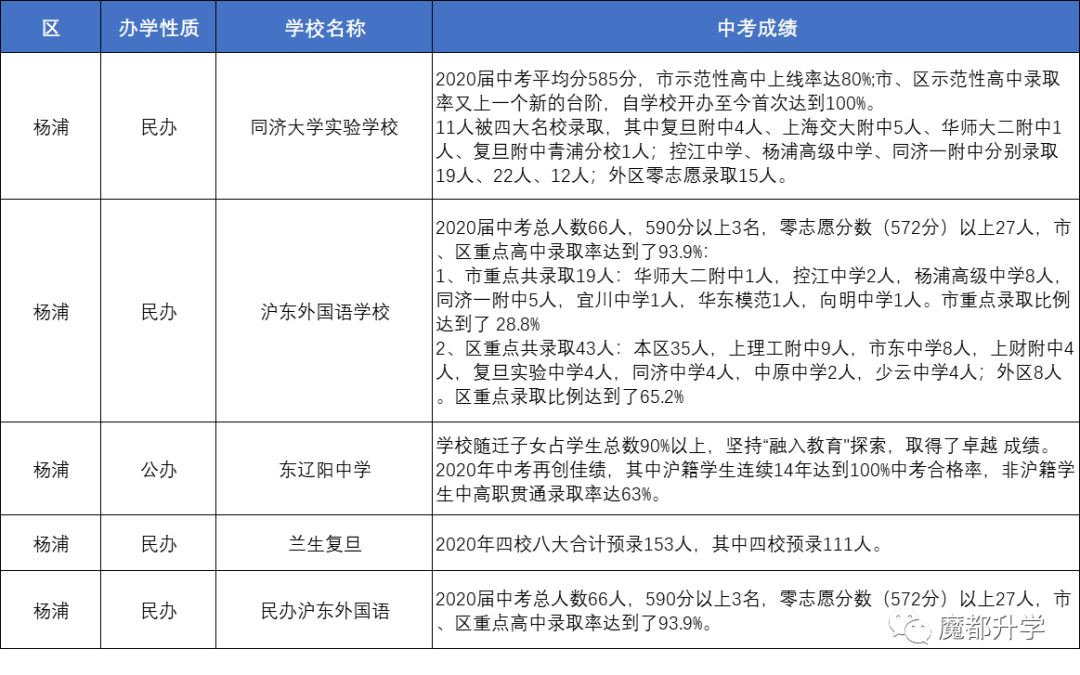

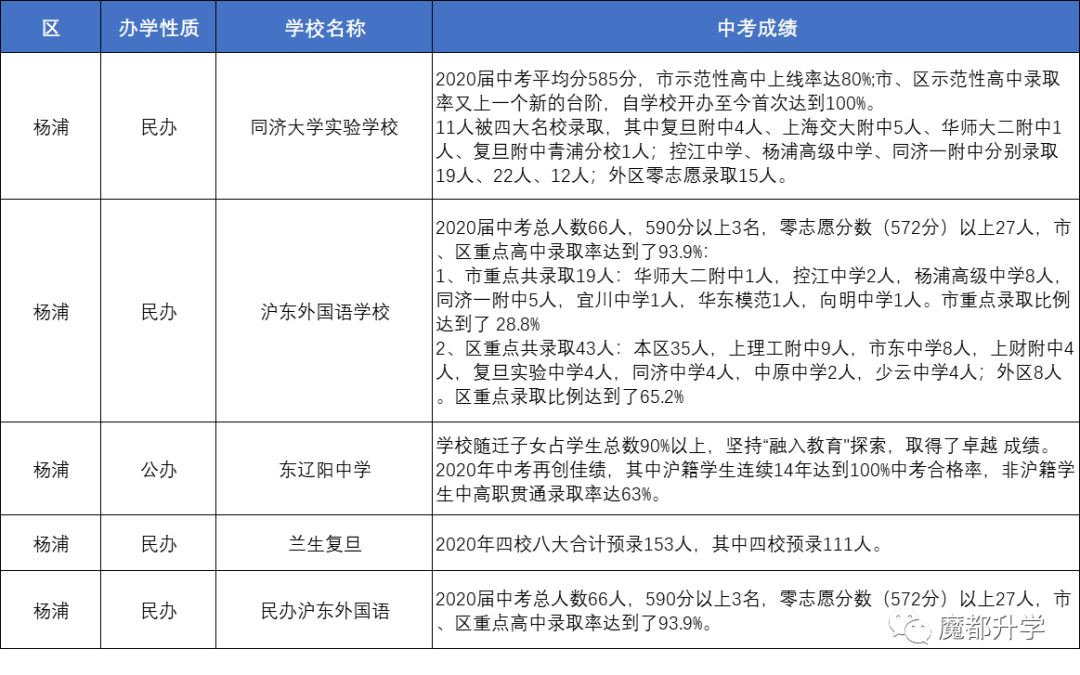

杨浦区

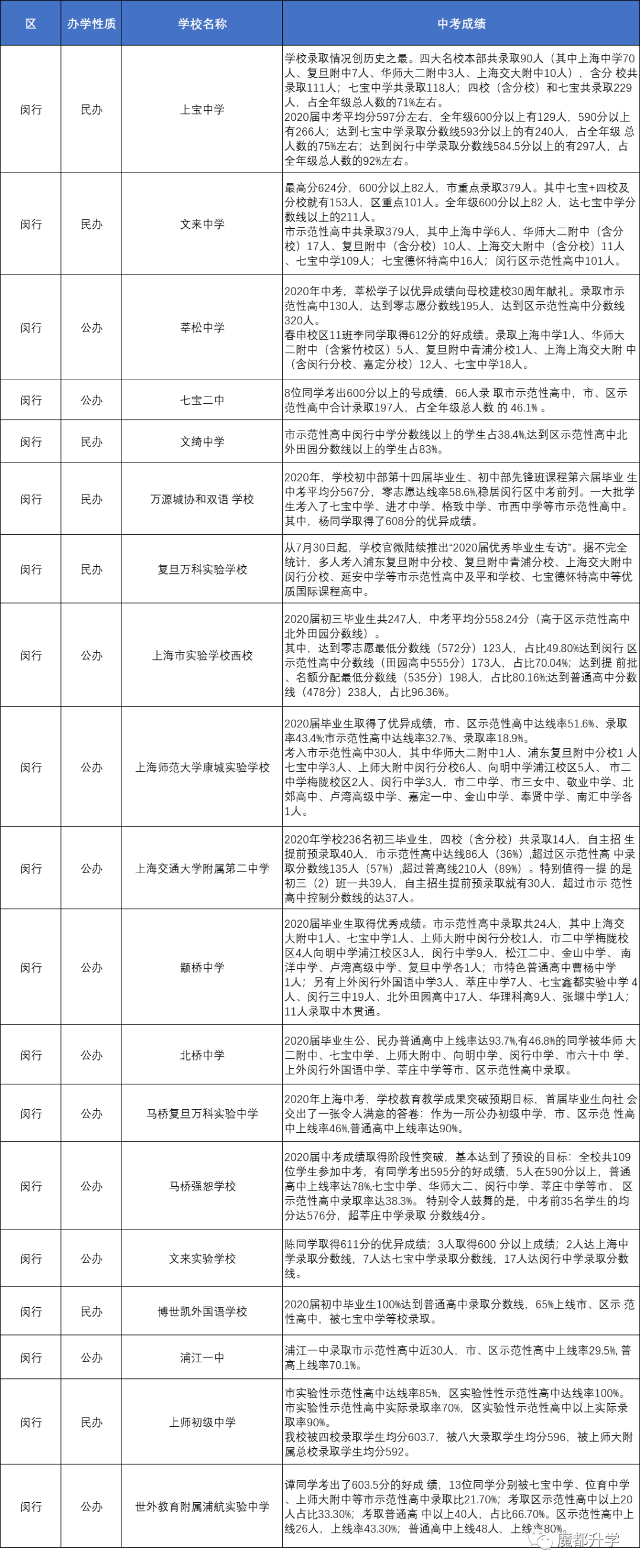

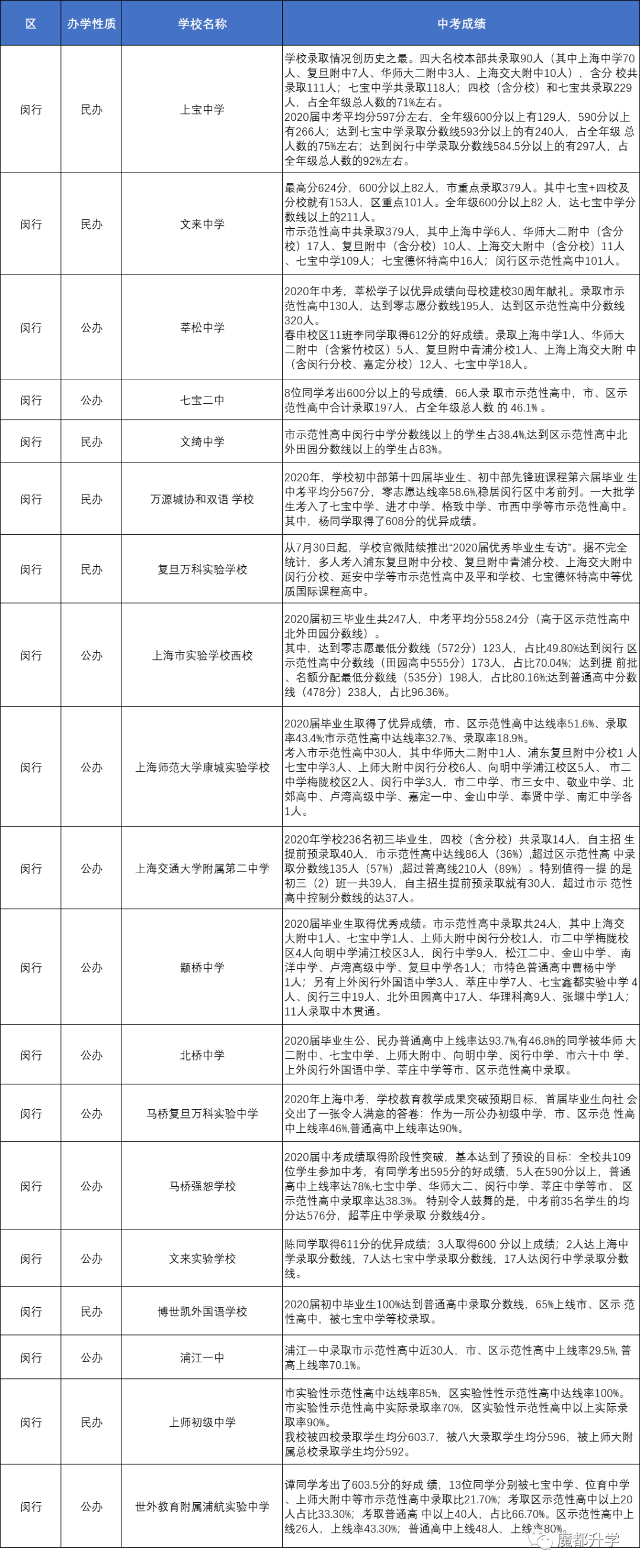

闵行区

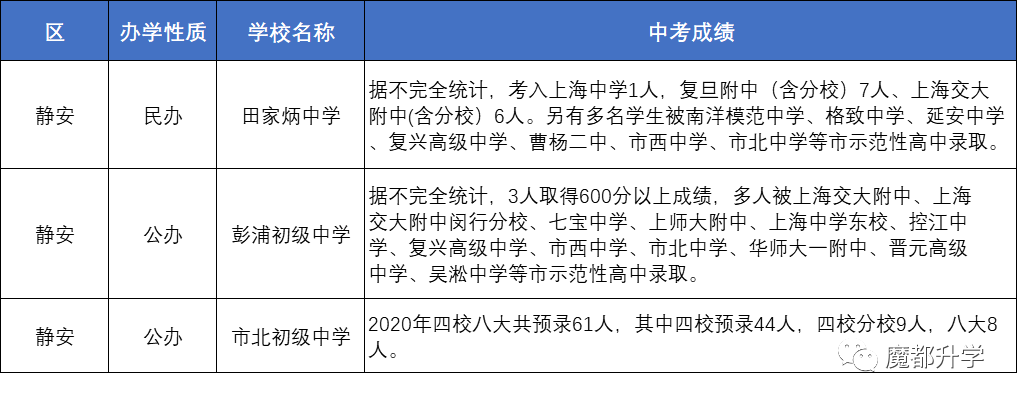

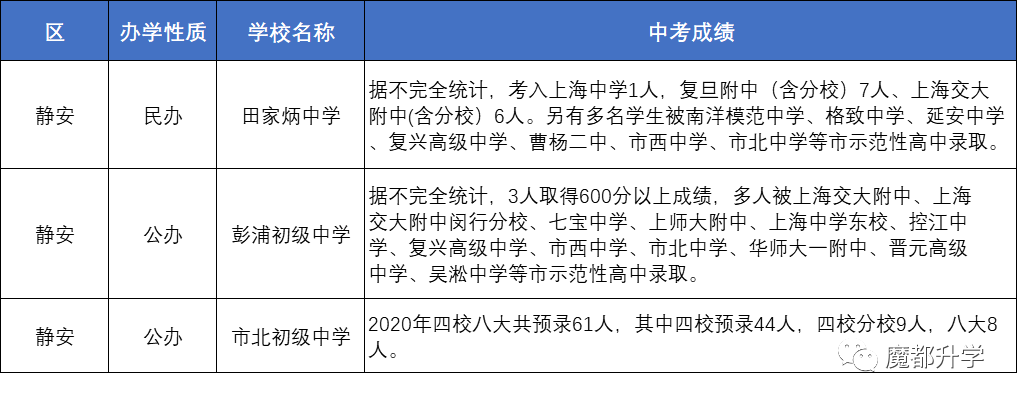

静安区

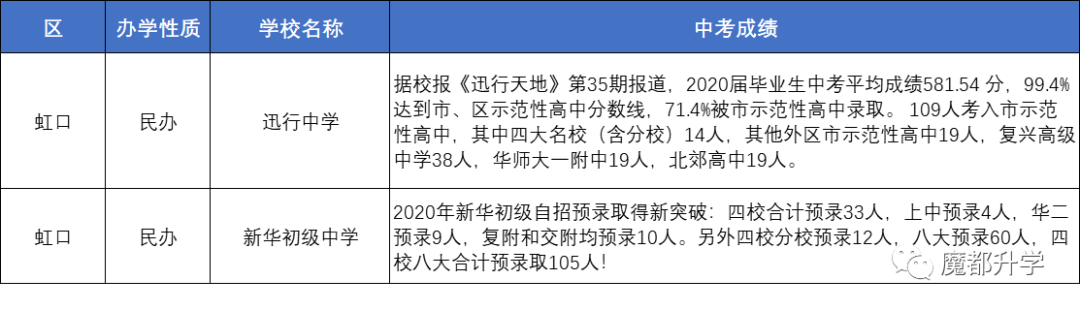

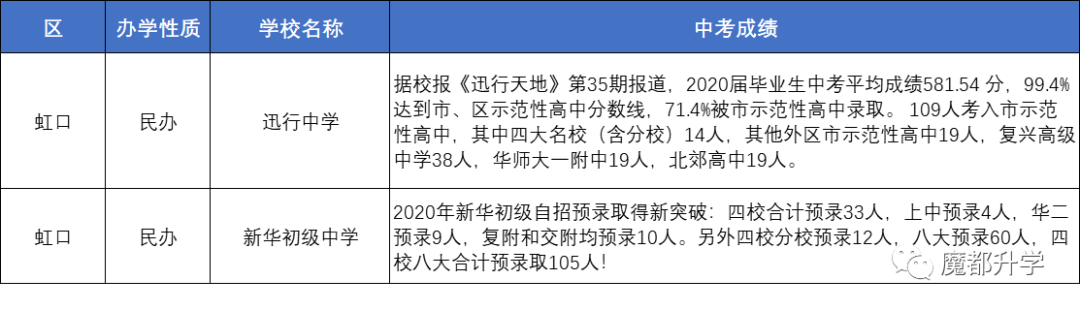

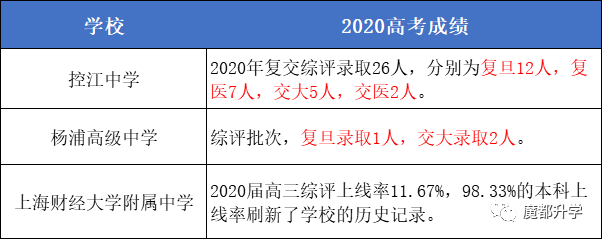

虹口区

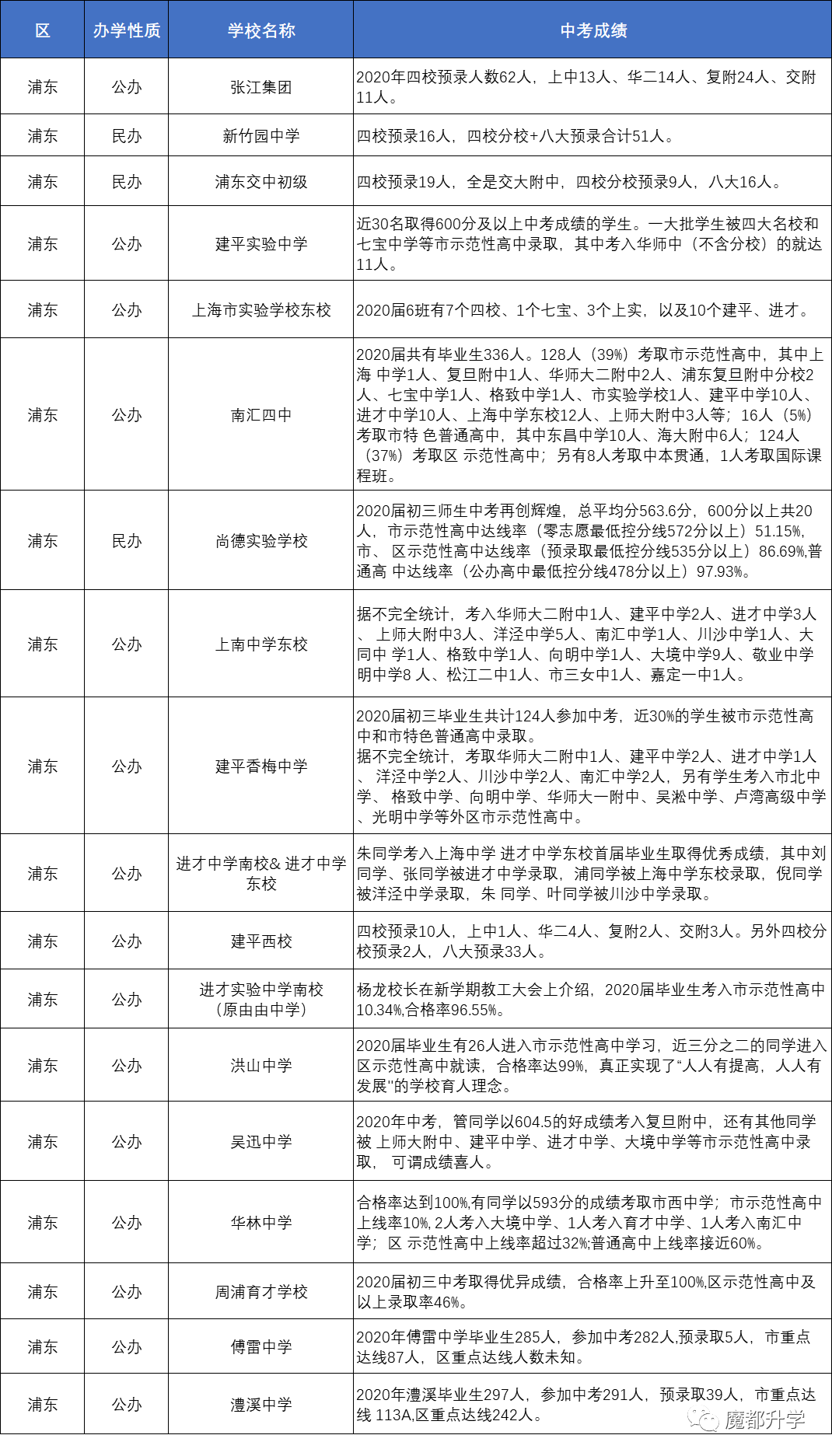

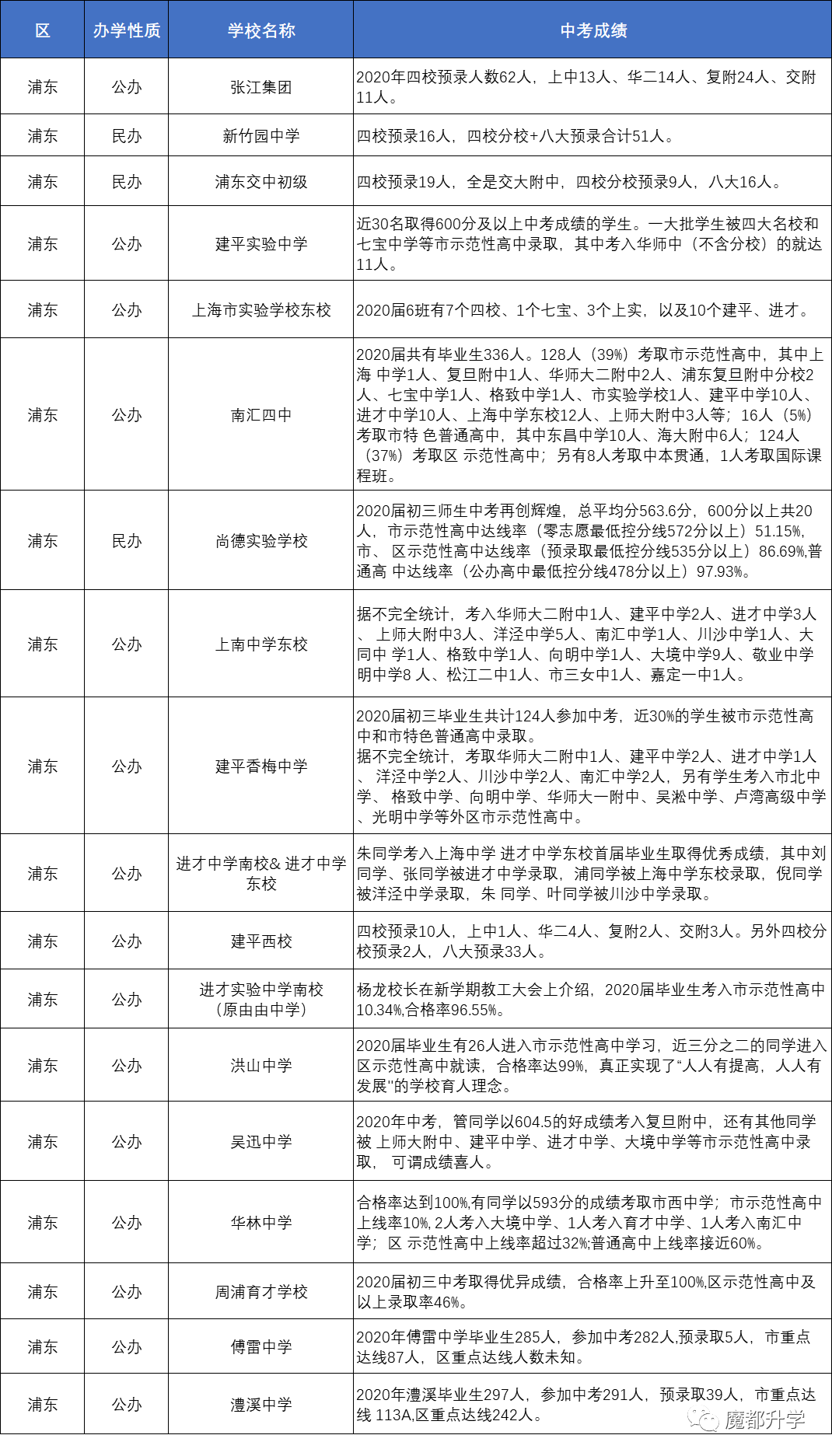

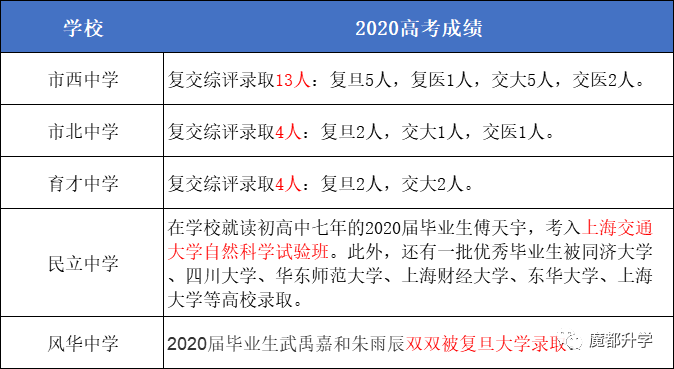

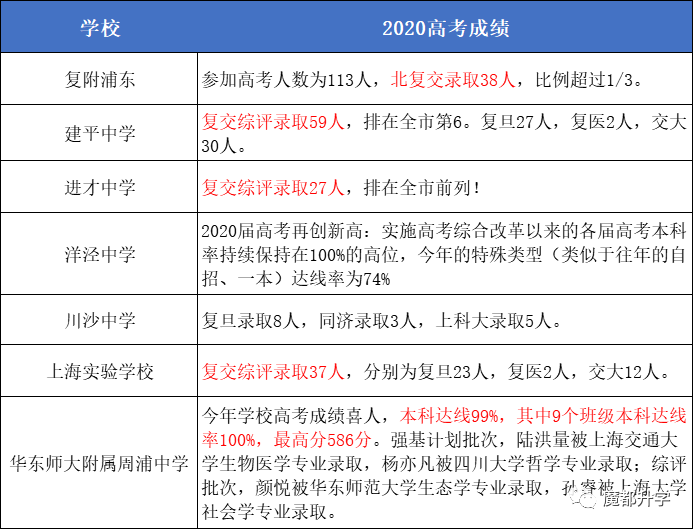

浦东新区

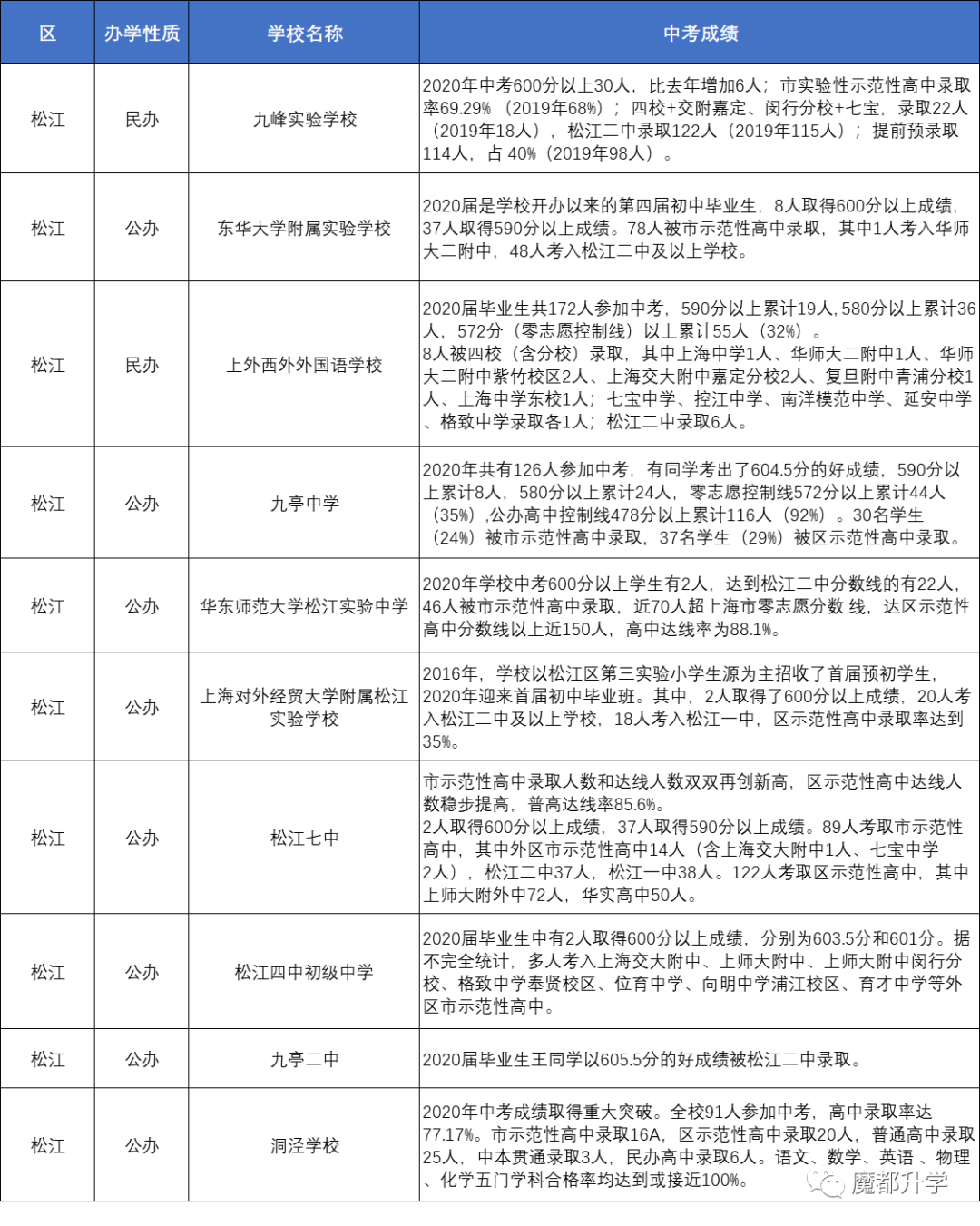

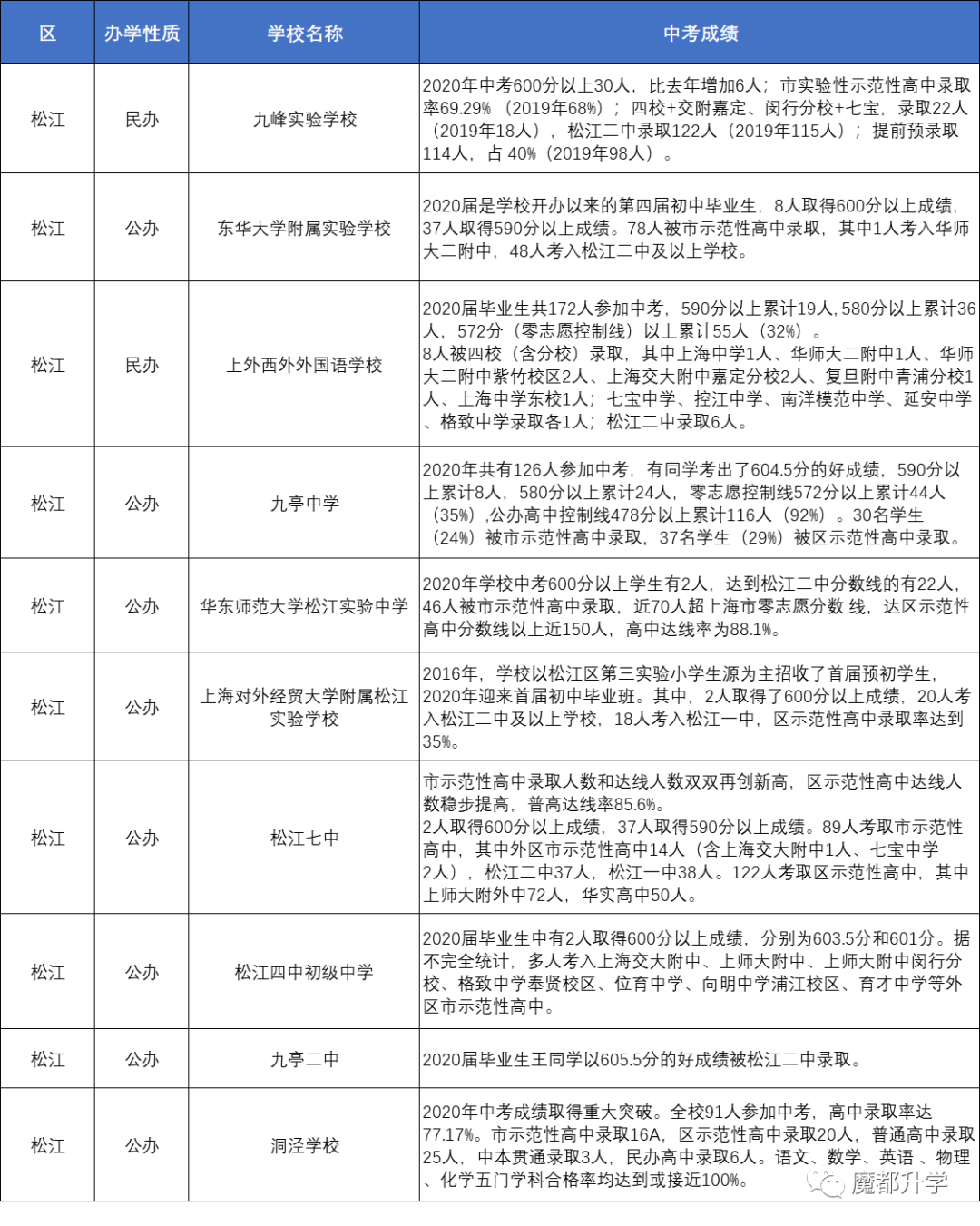

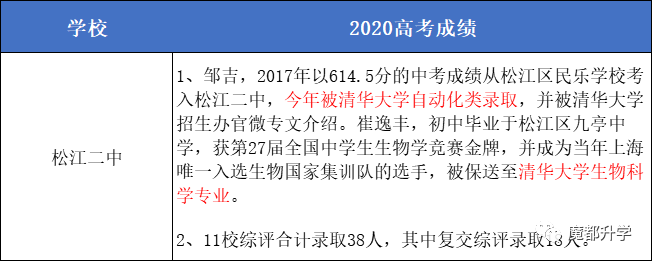

松江区

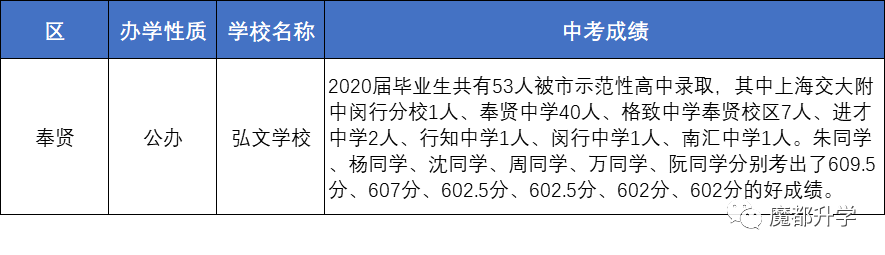

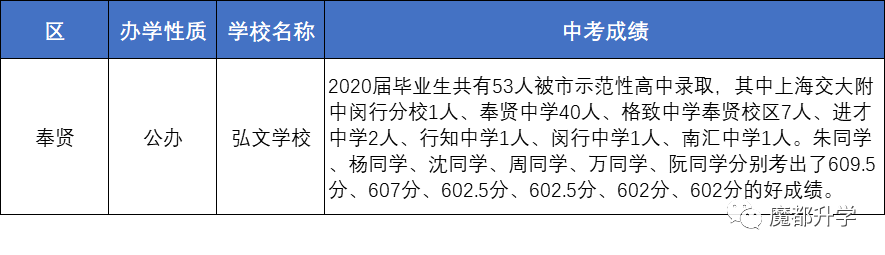

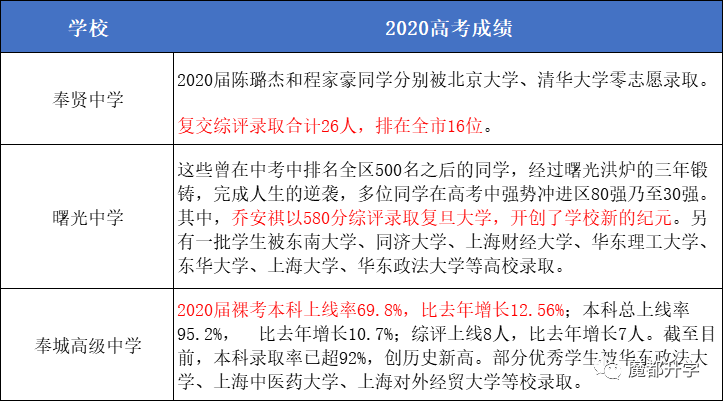

奉贤区

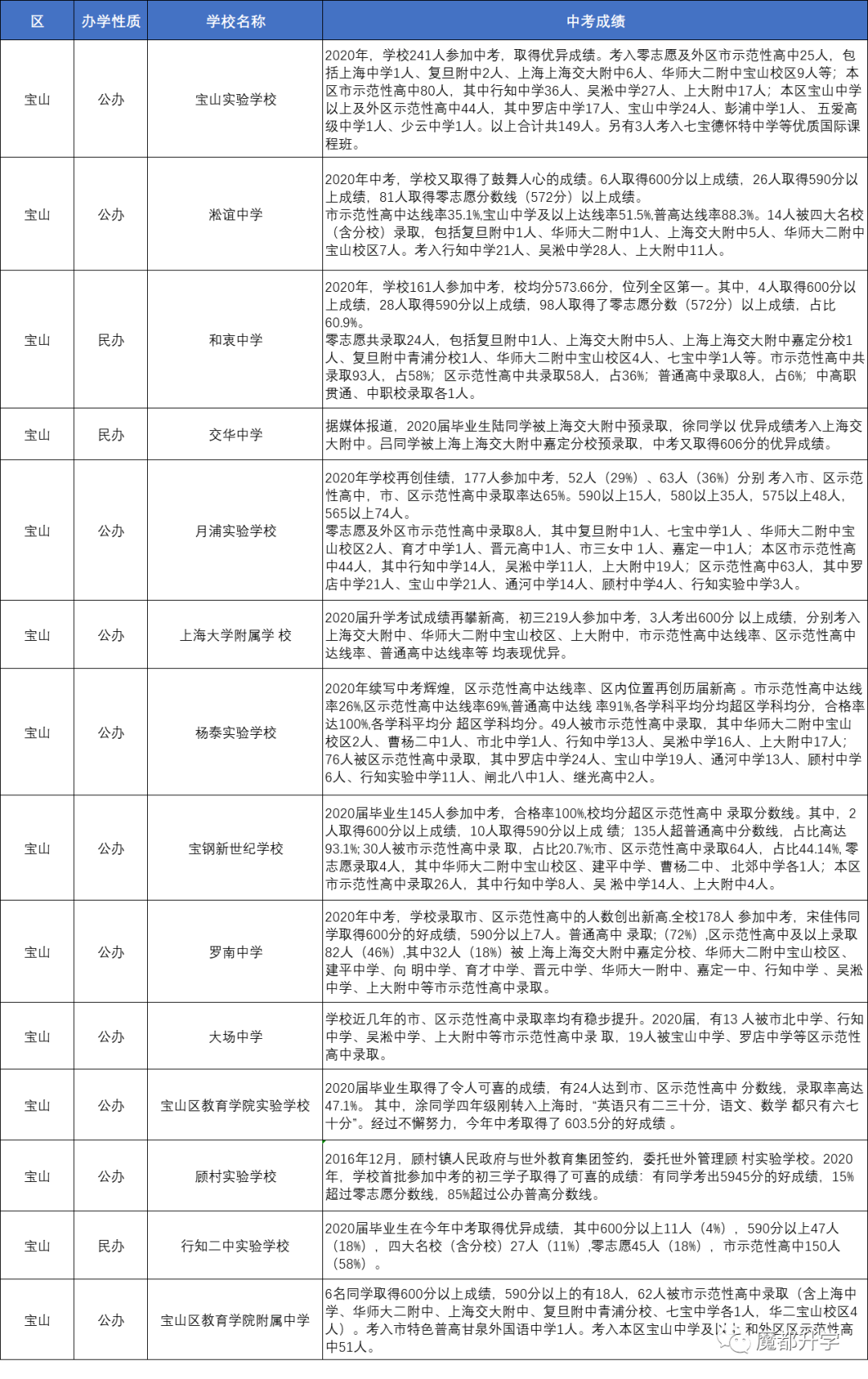

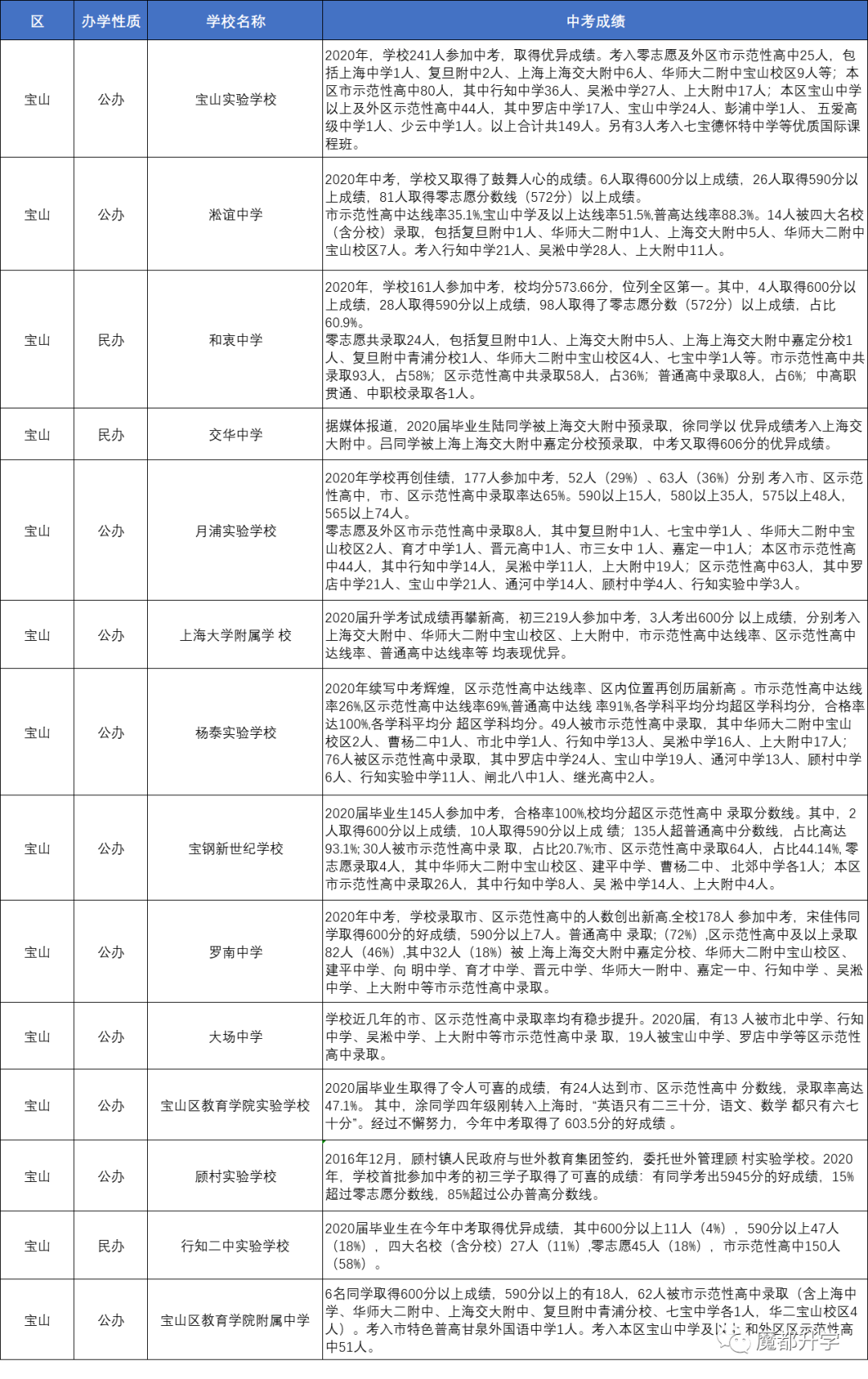

宝山区

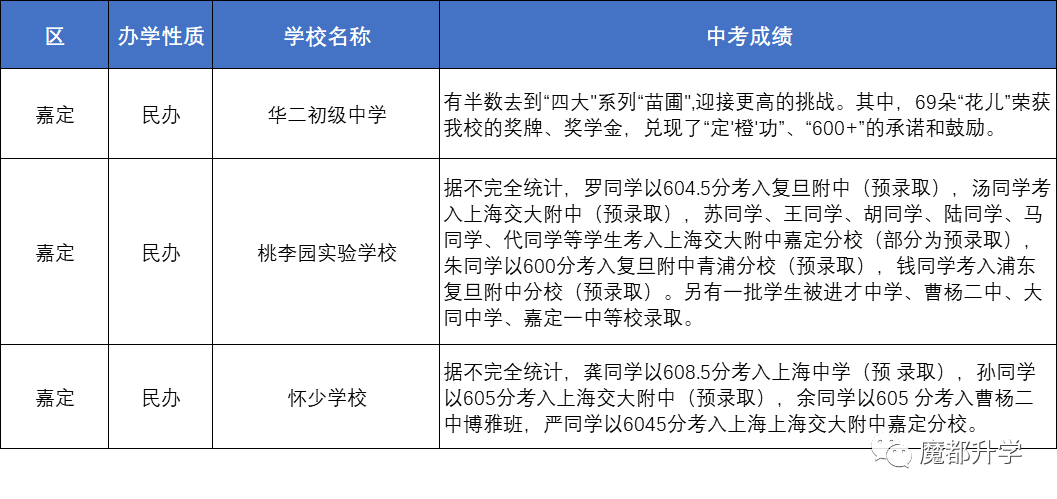

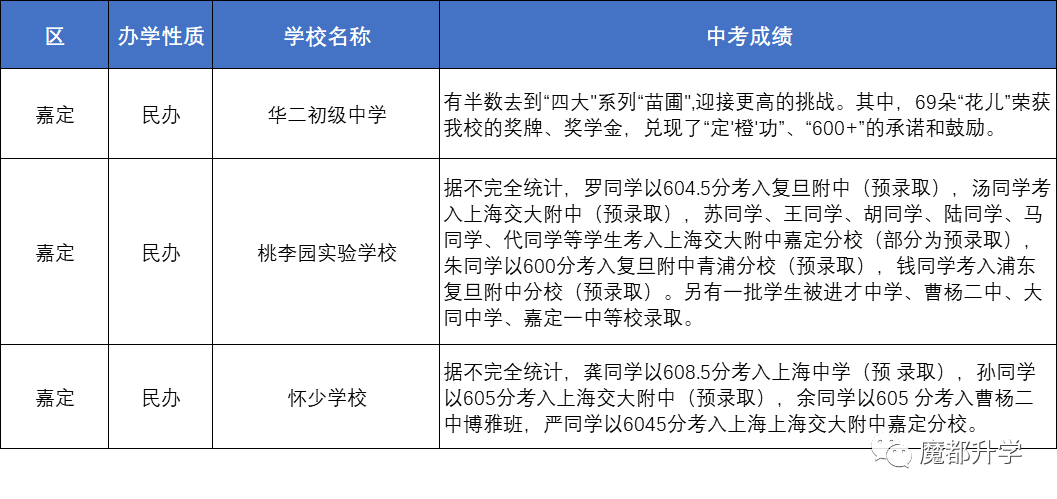

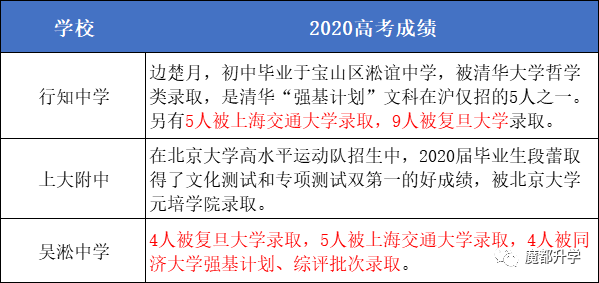

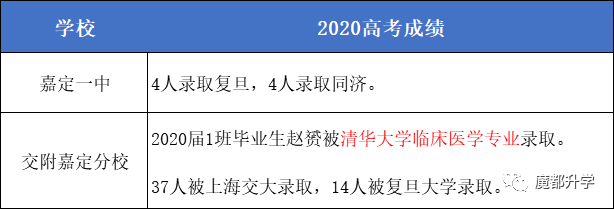

嘉定区

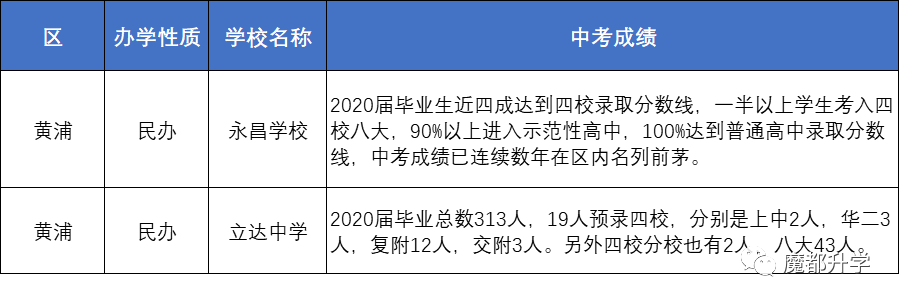

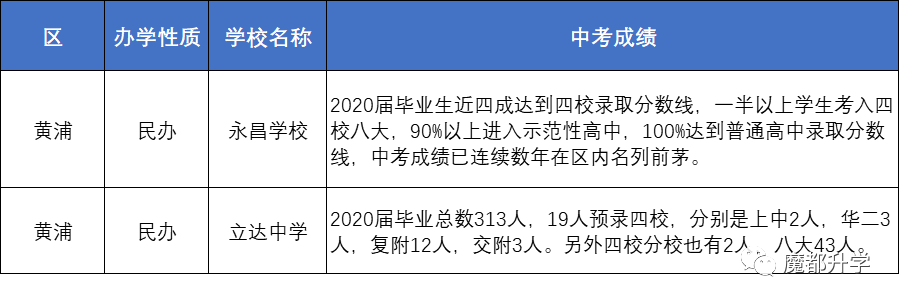

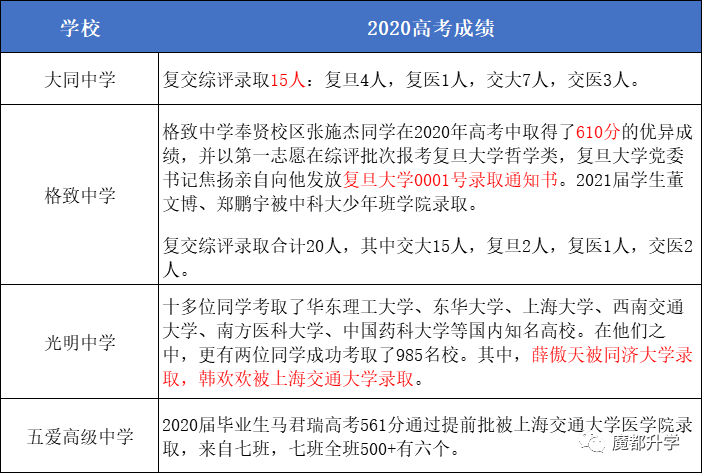

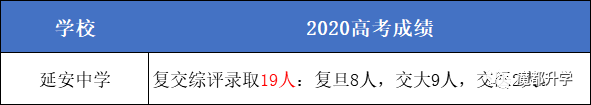

黄浦区

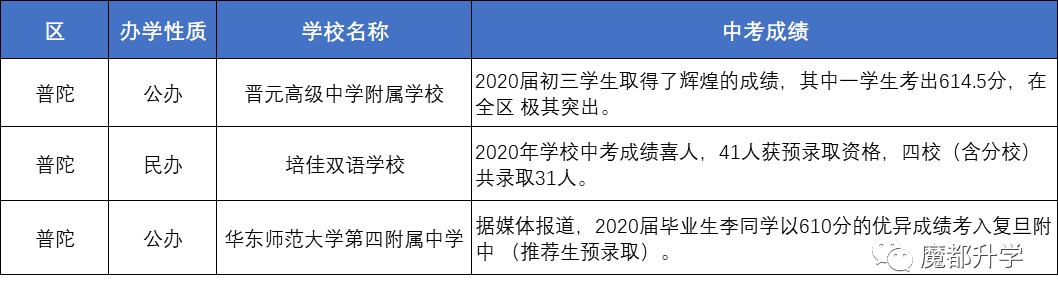

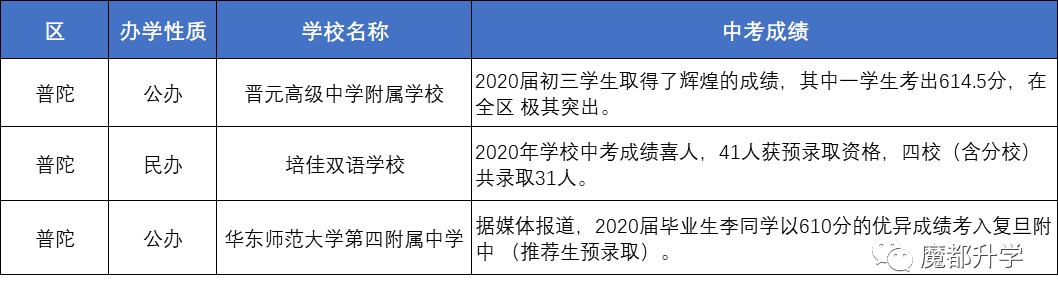

普陀区

长宁区

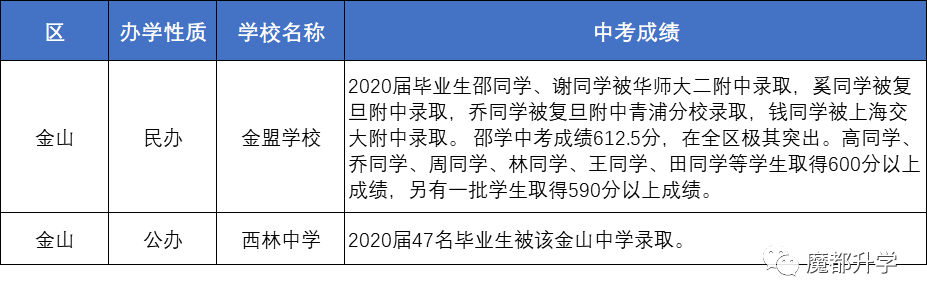

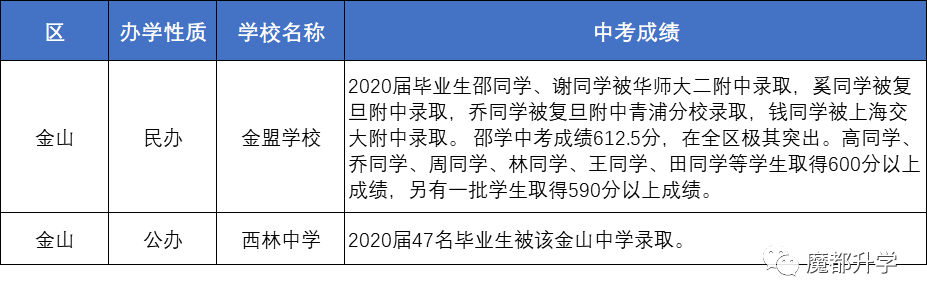

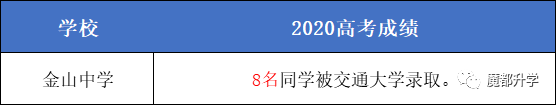

金山区

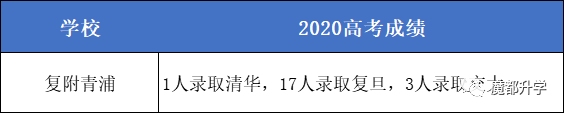

青浦区

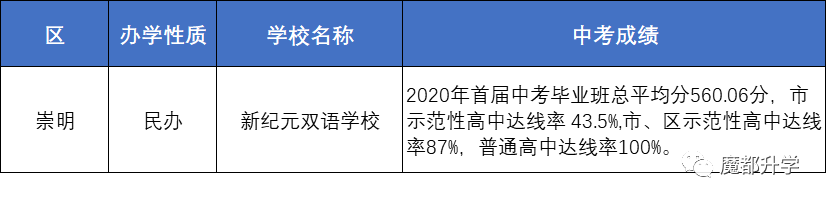

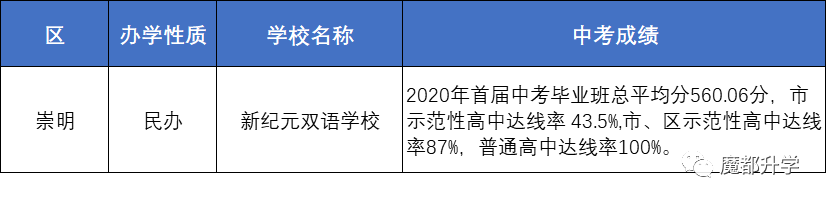

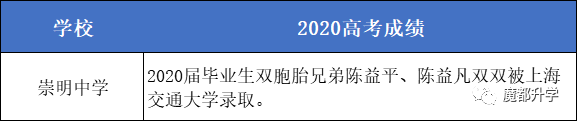

崇明区

转自:https://mp.weixin.qq.com/s/hetp8bMMdGcLfoETaDefkA

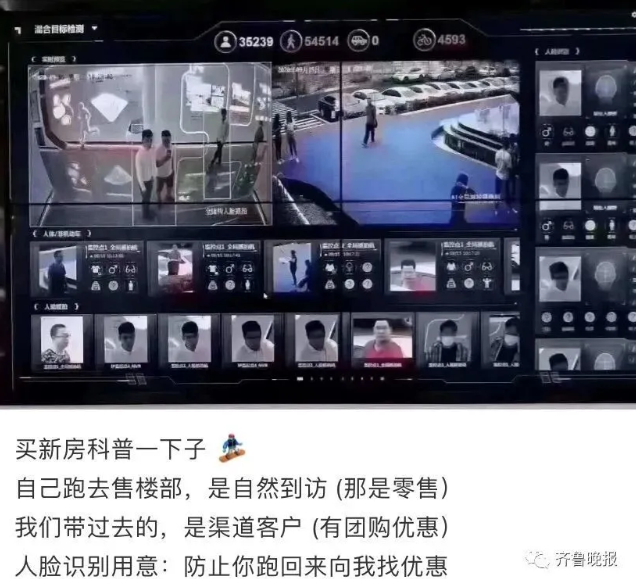

“经营者定价,应当遵循公平、合法和诚实信用的原则。”

经营者不得有以下不正当价格行为:提供相同商品或者业务,对具有同等交易条件的其他经营者实行价格歧视;

收集、使用个人信息,应当遵循合法、正当、必要原则,公开收集、使用规则,明示收集、使用信息的目的、方式和范围,并经被收集者同意。

转自:https://mp.weixin.qq.com/s/PpkmYbFn0YDvm9trNwoLSQ

股市有风险,投资需谨慎;

专注大趋势,不负好时代。

市场继续震荡,有人担心久盘必跌,我却并不怎么担心。

因为我知道,不管短期走势怎么样,如果把周期拉长看,后市极大概率会往上。无非,时间磨久点,过程曲折点。

这是我炒股生涯,第三次顿悟所悟到的。我在学炒股过程中,努力摸索,碰壁无数,一共有过4次顿悟,今晚和大家简单分享一下。

第一次顿悟,是从“缠师”那里学到了一句话,“走势终完美”。

这句话从辩证角度包含两重意思:第一,一个走势一旦形成,一定会走到结束;第二,一个走势不管持续多久,最终一定会结束。

对于前者,我从此理解了“趋势中继”;对于后者,我从此理解了“趋势转折”。后来我炒股,就只做“强势股的第二波”(趋势中继),或者只找那种“跌了一年半以上,股价放量站上年线再缩量回踩年线的”(趋势转折)。

第二次顿悟,是学会了放弃绝大部分普通的机会,只做非常有特色的机会。

理解了趋势中继和转折,却并没有给我炒股带来稳定盈利。对此,我百思不得其解。直到有一天,我又一次醒悟:原来炒股赚钱和亏钱是不对称的,净值从1涨到1.5需要赚50%,而净值从1.5跌回1只需要亏33%。

所以,我们必须尽量避免大量平庸的、可能给我们资金带来磨损的交易,去主动拥抱极有特色、非常犀利的交易。

比如做短线,怎么定义强势股?强势有两种表现:一是股价涨停,天天涨停;二是股价新高,天天新高。不是涨停和新高的股票,短线就没必要去碰。

比如做中线,怎么定义强势股?必须是某一段时间的明星股,是江湖到处谈论、人们津津乐道的股票。不是这种,也没必要去碰。

第三次顿悟,是学会做大周期,从此无招胜有招。

第二次顿悟以后,我开始持续稳定从股市赚钱,但也有个问题,就是赚得太辛苦。其实这根本不算问题,世间360行,没几个行业是不辛苦的,炒股已经算是比较轻松的手艺。

但我还是努力想如何去偷懒,偷懒是推动社会进步的重要原动力之一。过了很久,我终于找到了方法,就是:周期越大,市场越容易分析。并且,周期越大,对操盘手法的要求越低。

比如,从超大周期来看,A股几十年都是底部不断抬升的,那么只要选择指数定投,或者直接持有部分指数,几乎已经立于不败之地。所以后来我又越来越喜欢和推荐指数化交易(买指数ETF)。

周期做大以后,对买卖点的精准度也没什么要求了。只要牢牢把握“上升趋势逢低做多”“好的买点总在调整后”等几个简单口诀,就可以把股票炒好。因为,感觉大差不离的时候,分批买分批卖就行了,既无踏空,也无挨套。

另外,周期做大以后,还不再容易受市场短期波动所扰、所惑,心态也变得更好起来,这真是一个意外收获。

第四次顿悟,是跳出股市看股市,知道赚钱最重要,从哪里赚的不重要。

炒股赚钱重要的不是收益率,而是绝对数。假如你一共10万本金,某年大行情翻1倍,也就才赚10万。而假如林老板1000万本金,当然他远不止1000万本金,只要赚10%,就有百万进账。你觉得你翻1倍他赚10%,你就比他牛?显然不是的。

所以,其实并不需要拘泥于炒股,什么项目能赚钱,回报和投入的比率相对较高,就去做什么。炒股赚的1万元,只能当1万元花,做其他事情如果赚1万元,也能当1万元花,为什么非要把自己局限在股市里呢?

还有,股票为什么非要自己去炒?把钱交给一个专业的人去干,也许比自己干得更好。就算和自己干得差不多,至少自己的时间省出来,可以去做别的事积累更多本金……

悟到这里以后,我就开始不炒股了,把钱交给我们团队的基金经理何老师去打理,自己专心负责公司运营事务,去做服务和保障。

我的炒股历程,从不炒股开始,到最后回到不炒股,却经历了一个十几年的循环,一次十几年的升华。

转自:https://mp.weixin.qq.com/s/0iTFU2HnQ_uPF3_JBgMfVg

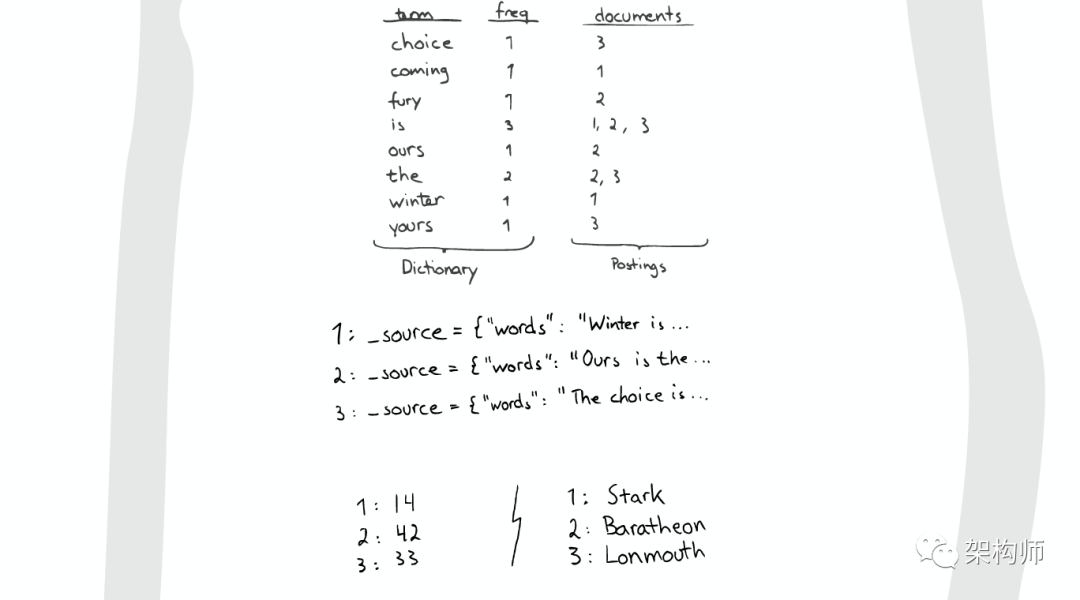

先自上而下,后自底向上的介绍ElasticSearch的底层工作原理,试图回答以下问题:

为什么我的搜索 *foo-bar* 无法匹配 foo-bar ?

为什么增加更多的文件会压缩索引(Index)?

为什么ElasticSearch占用很多内存?

elasticsearch版本: elasticsearch-2.2.0

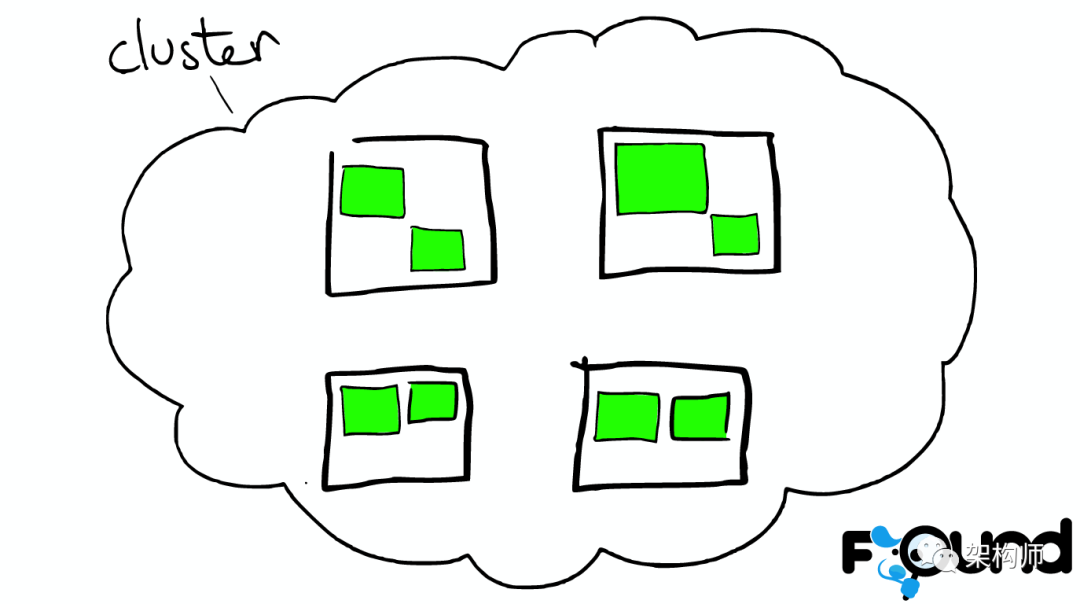

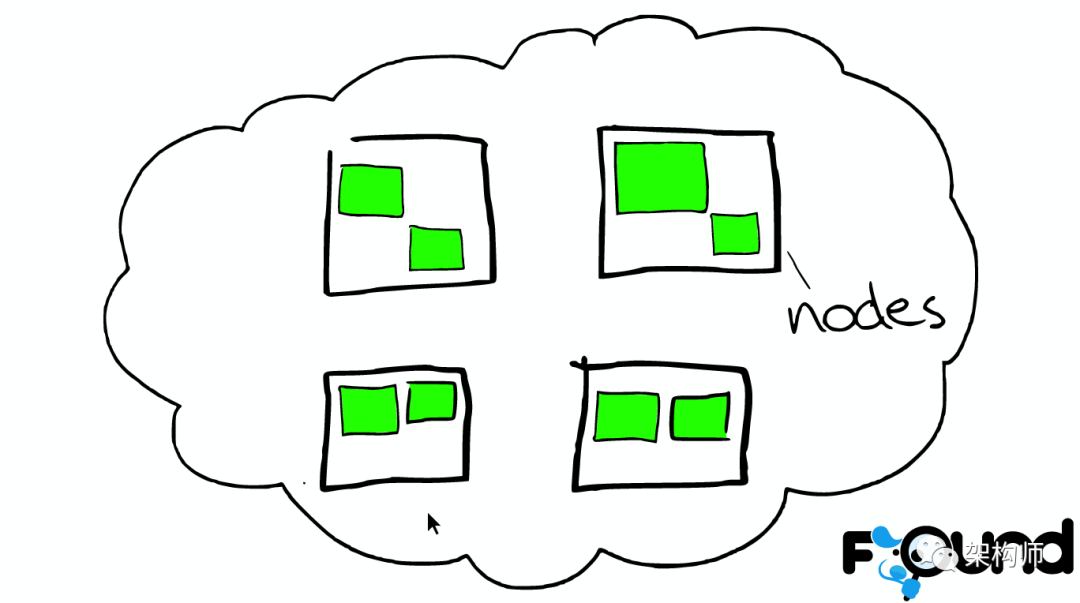

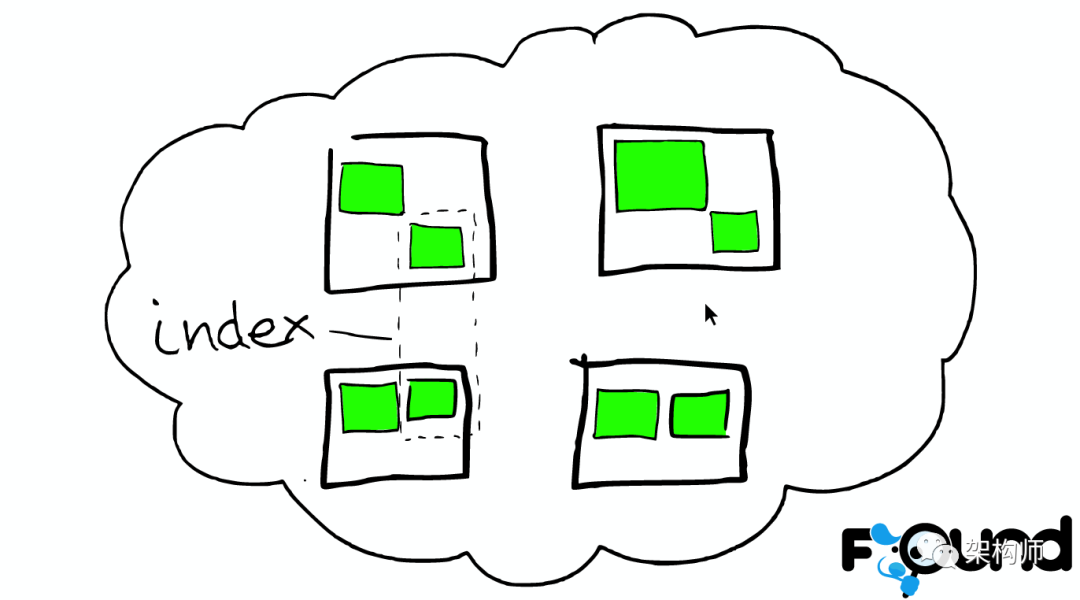

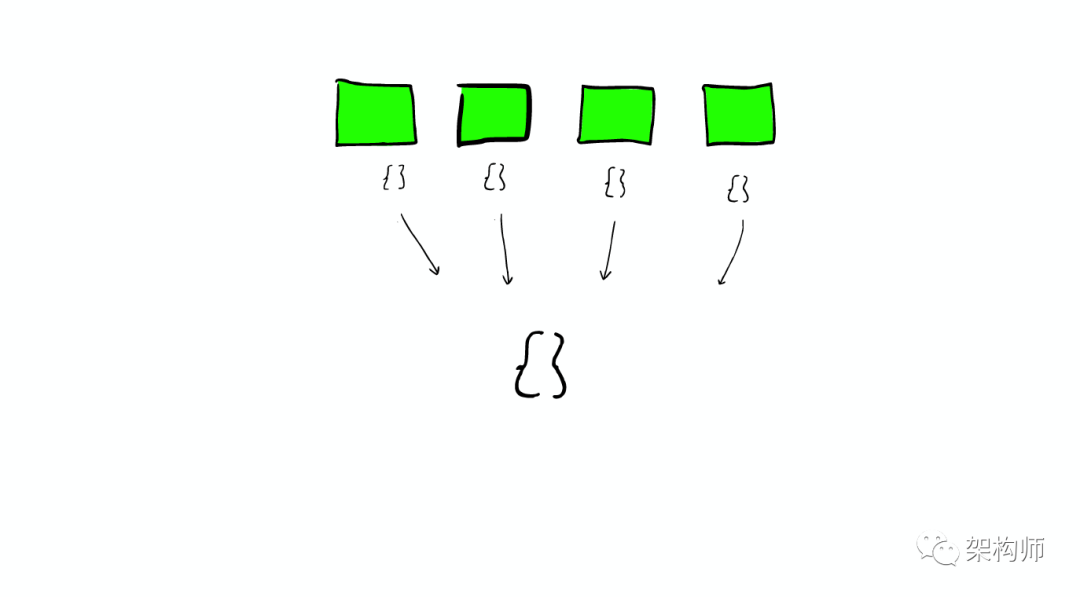

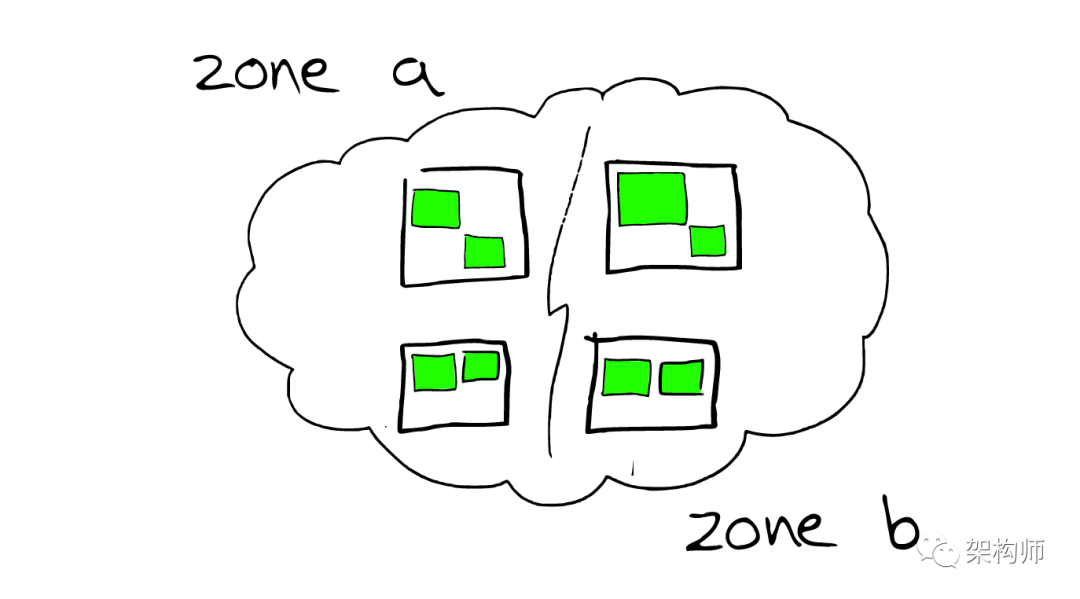

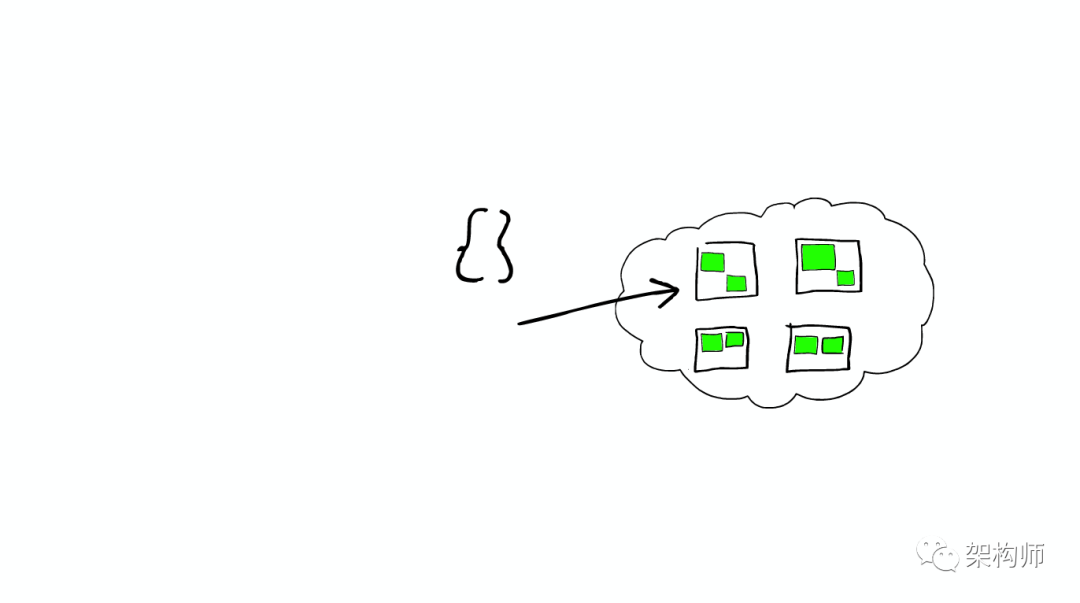

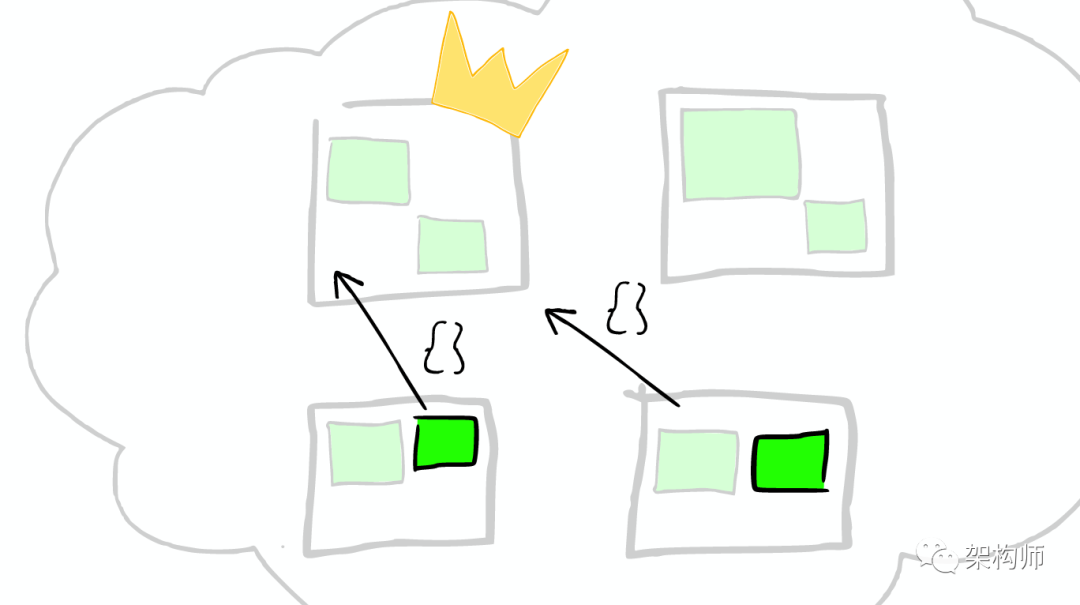

云里面的每个白色正方形的盒子代表一个节点——Node。

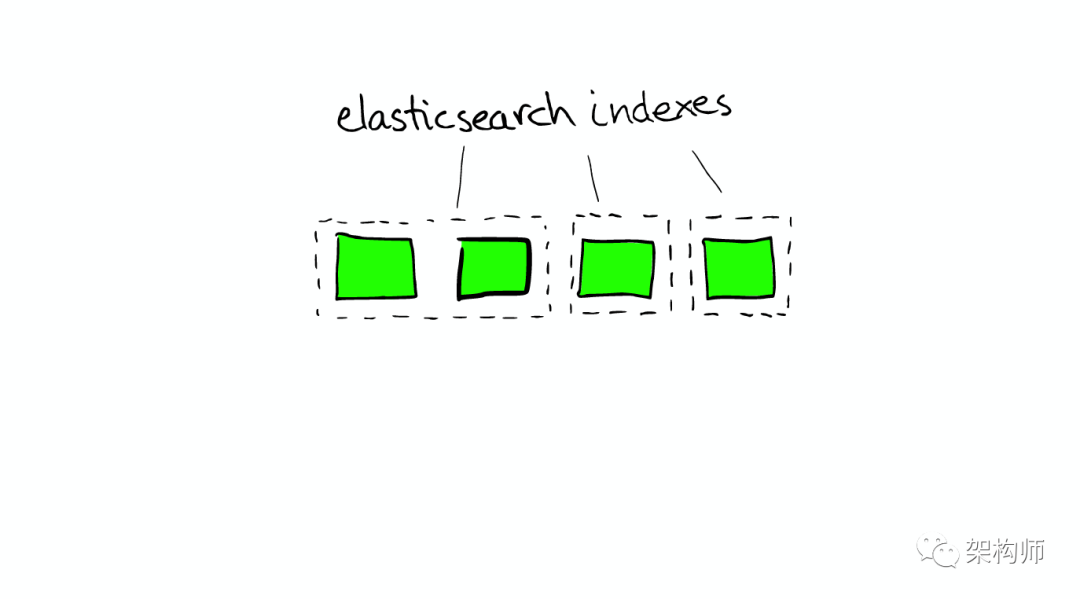

在一个或者多个节点直接,多个绿色小方块组合在一起形成一个ElasticSearch的索引。

在一个索引下,分布在多个节点里的绿色小方块称为分片——Shard。

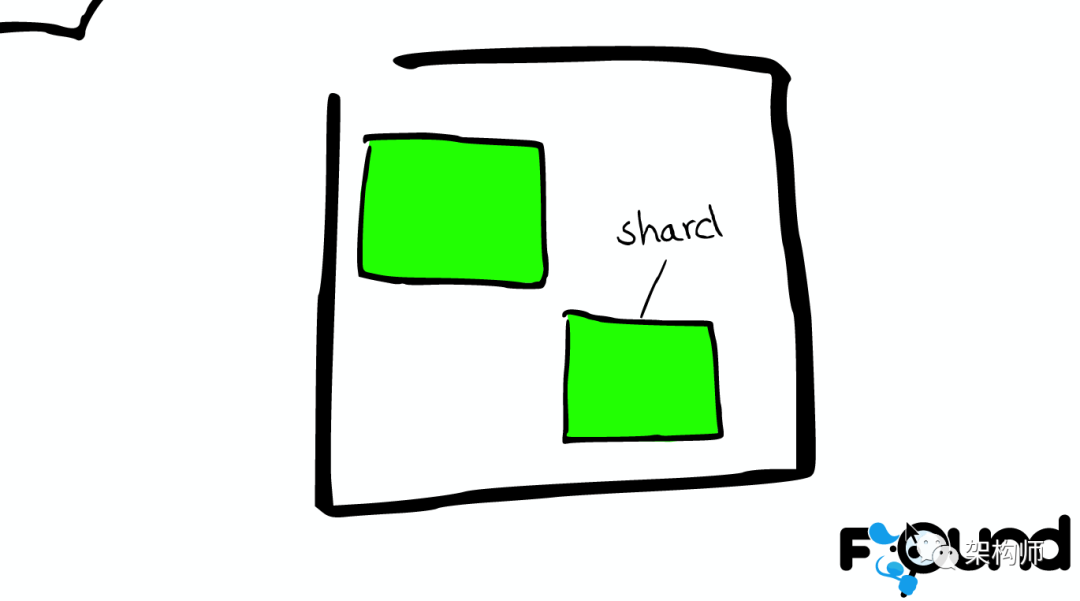

一个ElasticSearch的Shard本质上是一个Lucene Index。

Lucene是一个Full Text 搜索库(也有很多其他形式的搜索库),ElasticSearch是建立在Lucene之上的。接下来的故事要说的大部分内容实际上是ElasticSearch如何基于Lucene工作的。

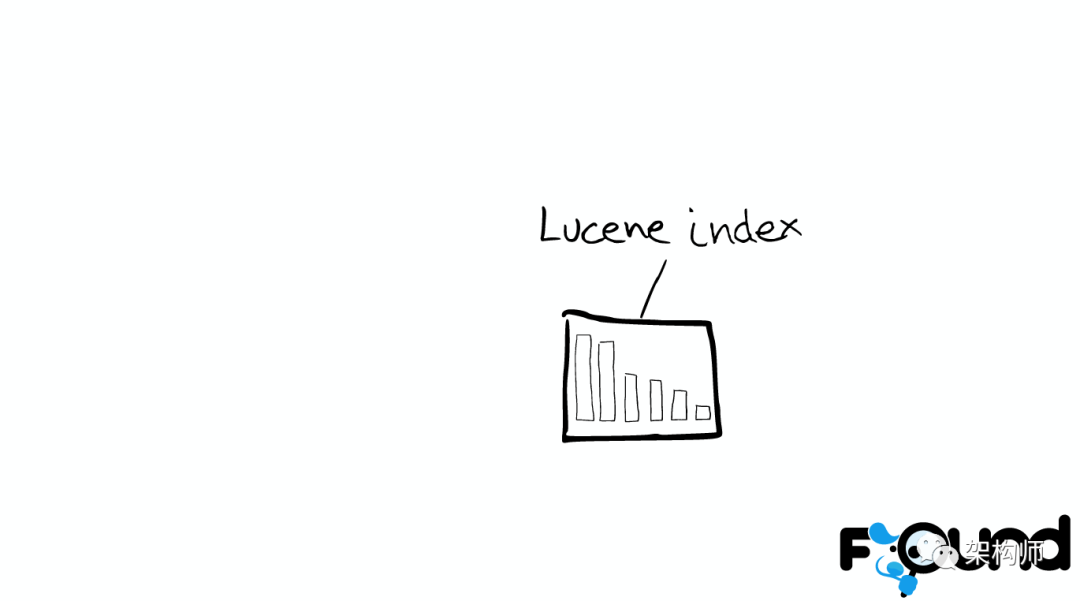

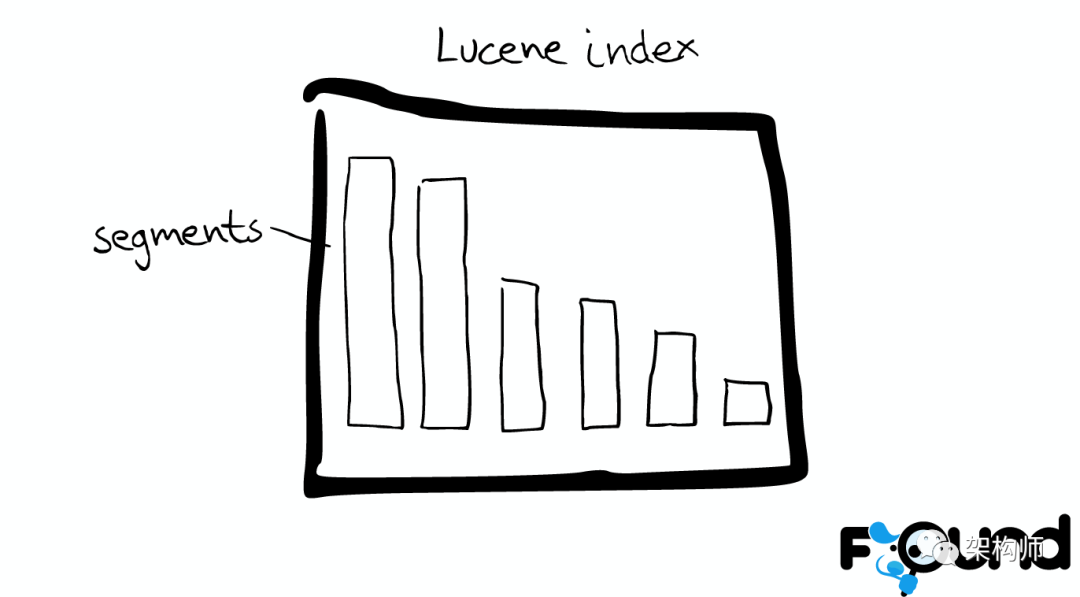

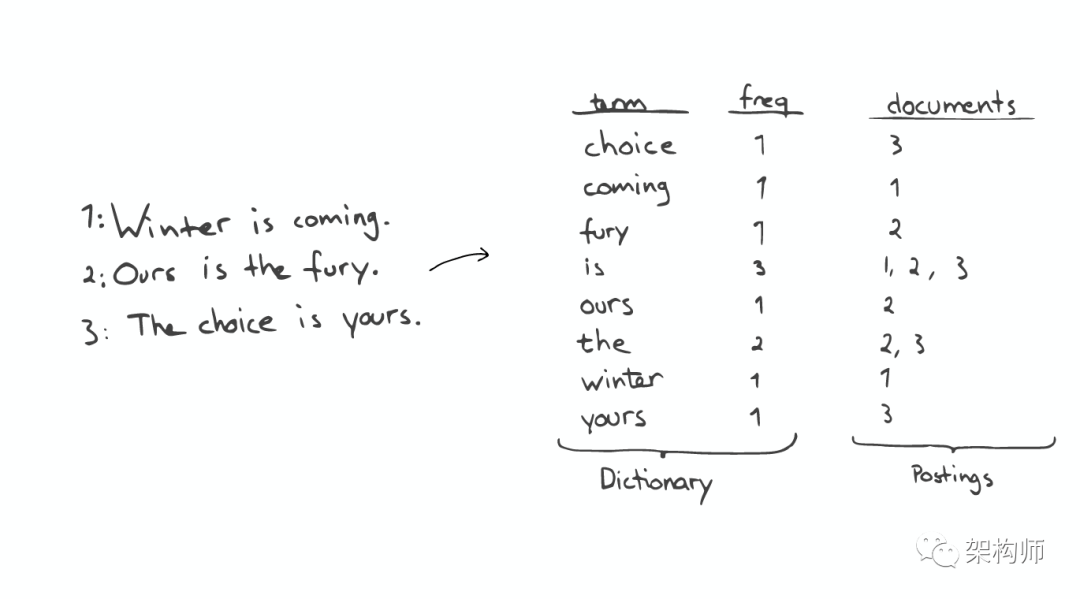

在Lucene里面有很多小的segment,我们可以把它们看成Lucene内部的mini-index。

有着许多数据结构

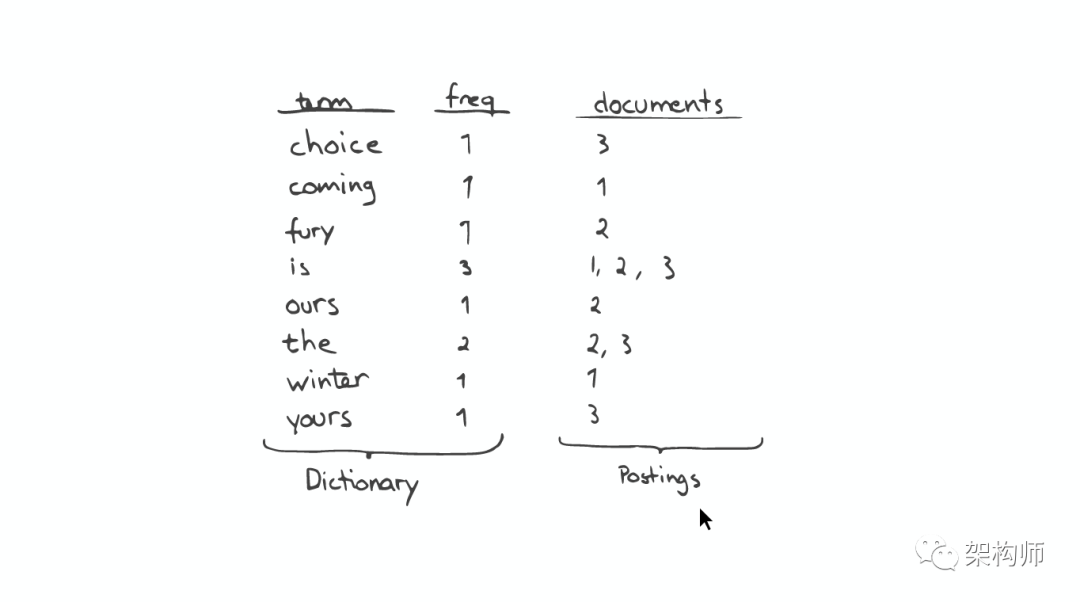

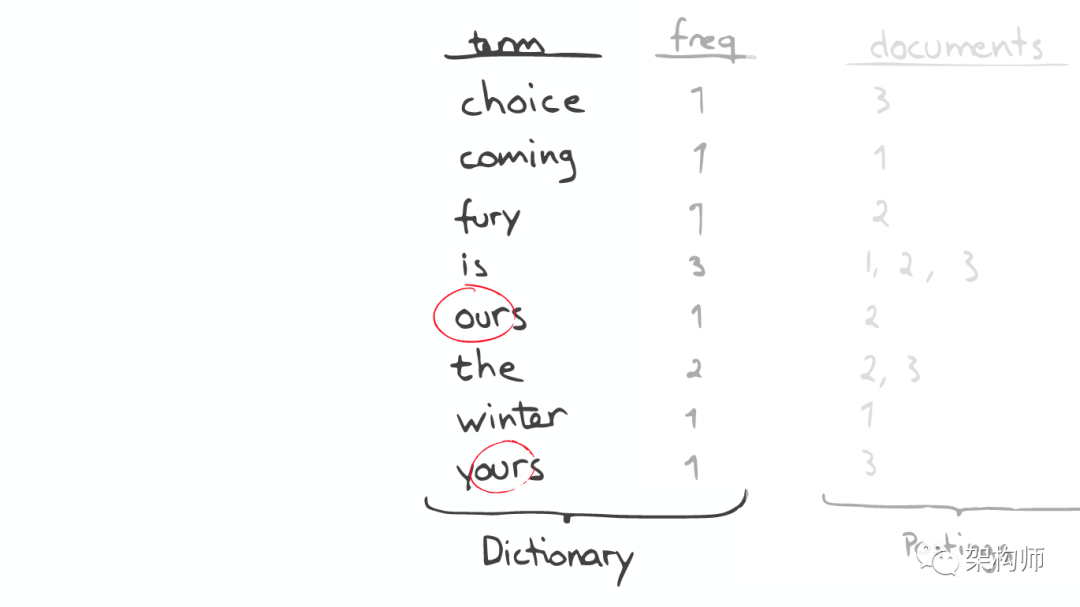

Inverted Index主要包括两部分:

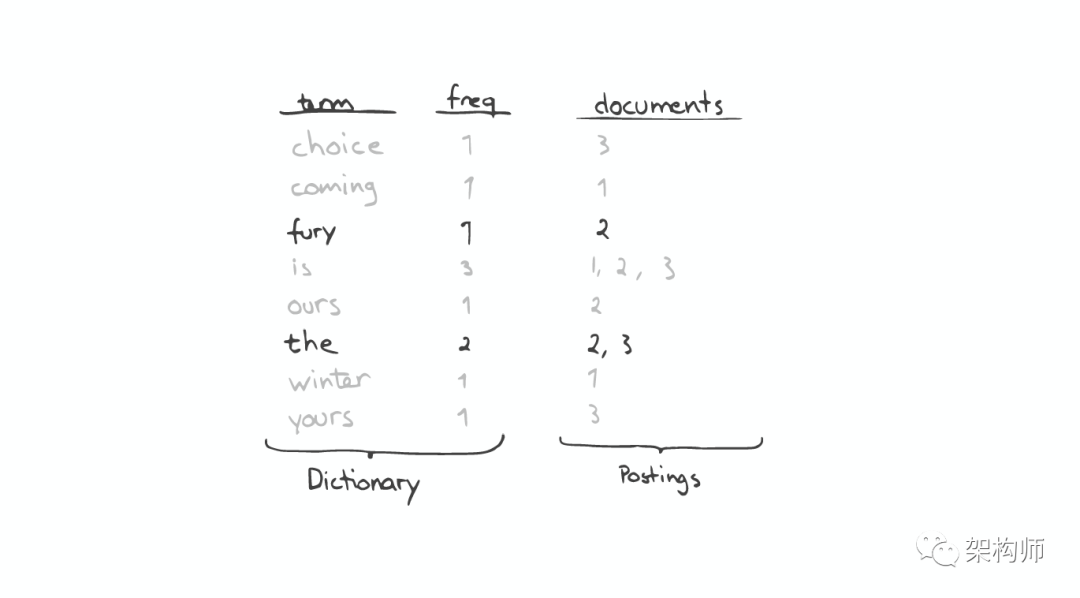

当我们搜索的时候,首先将搜索的内容分解,然后在字典里找到对应Term,从而查找到与搜索相关的文件内容。

如果想要查找以字母“c”开头的字母,可以简单的通过二分查找(Binary Search)在Inverted Index表中找到例如“choice”、“coming”这样的词(Term)。

如果想要查找所有包含“our”字母的单词,那么系统会扫描整个Inverted Index,这是非常昂贵的。

在此种情况下,如果想要做优化,那么我们面对的问题是如何生成合适的Term。

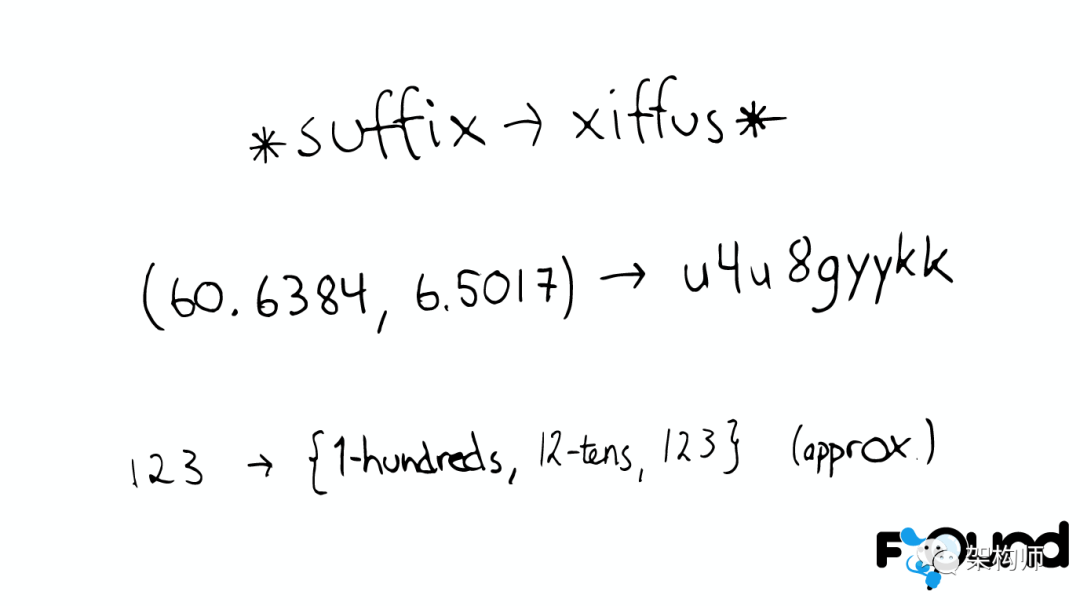

对于以上诸如此类的问题,我们可能会有几种可行的解决方案:

* suffix -> xiffus *

如果我们想以后缀作为搜索条件,可以为Term做反向处理。

(60.6384, 6.5017) -> u4u8gyykk

对于GEO位置信息,可以将它转换为GEO Hash。

123 -> {1-hundreds, 12-tens, 123}

对于简单的数字,可以为它生成多重形式的Term。

一个Python库 为单词生成了一个包含错误拼写信息的树形状态机,解决拼写错误的问题。

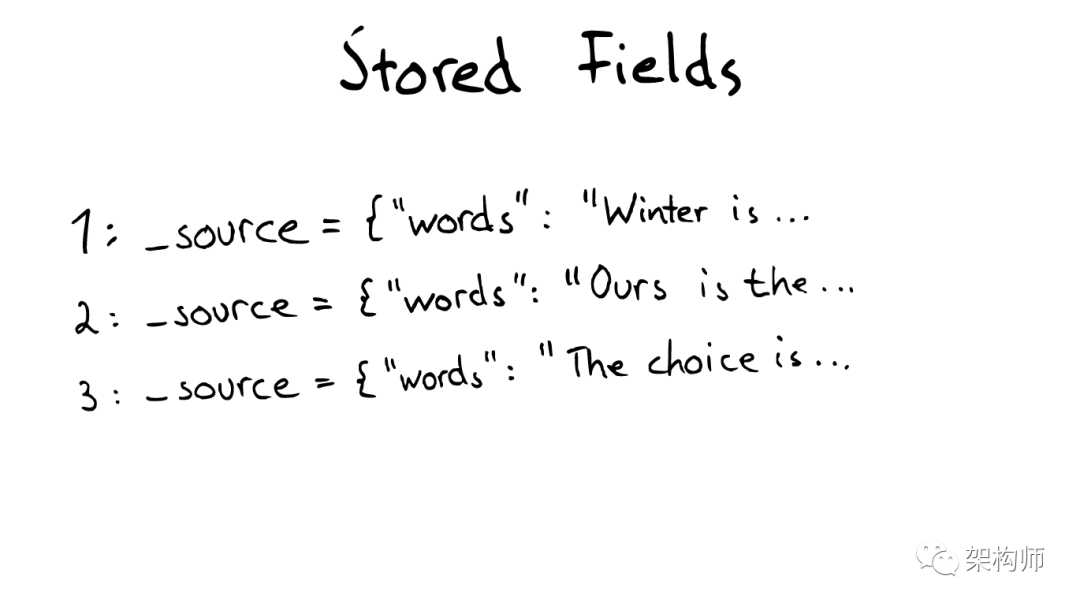

当我们想要查找包含某个特定标题内容的文件时,Inverted Index就不能很好的解决这个问题,所以Lucene提供了另外一种数据结构Stored Fields来解决这个问题。本质上,Stored Fields是一个简单的键值对key-value。默认情况下,ElasticSearch会存储整个文件的JSON source。

即使这样,我们发现以上结构仍然无法解决诸如:排序、聚合、facet,因为我们可能会要读取大量不需要的信息。

所以,另一种数据结构解决了此种问题:Document Values。这种结构本质上就是一个列式的存储,它高度优化了具有相同类型的数据的存储结构。

为了提高效率,ElasticSearch可以将索引下某一个Document Value全部读取到内存中进行操作,这大大提升访问速度,但是也同时会消耗掉大量的内存空间。

总之,这些数据结构Inverted Index、Stored Fields、Document Values及其缓存,都在segment内部。

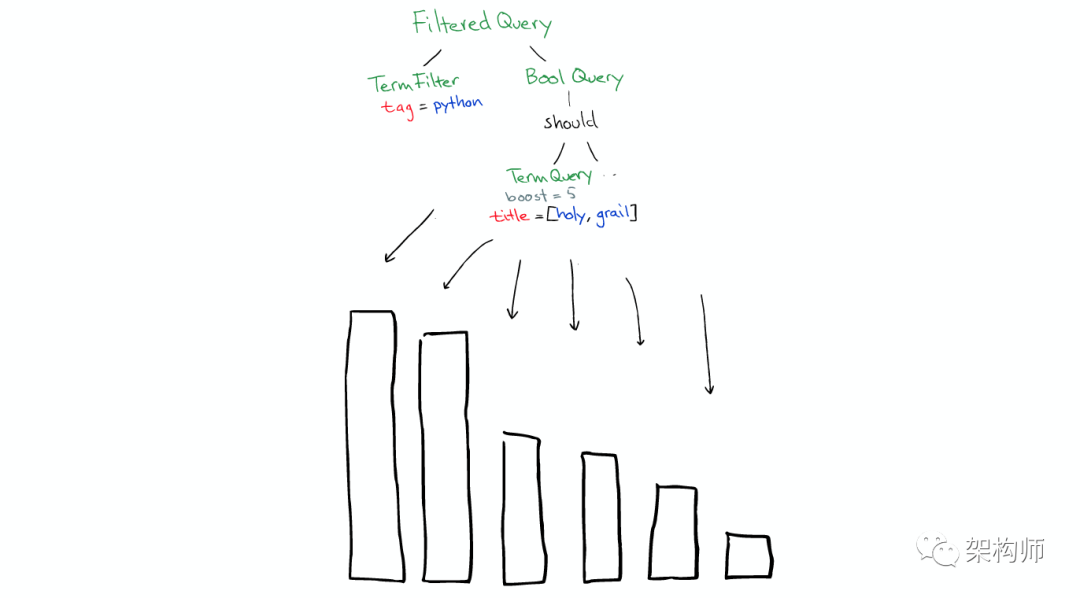

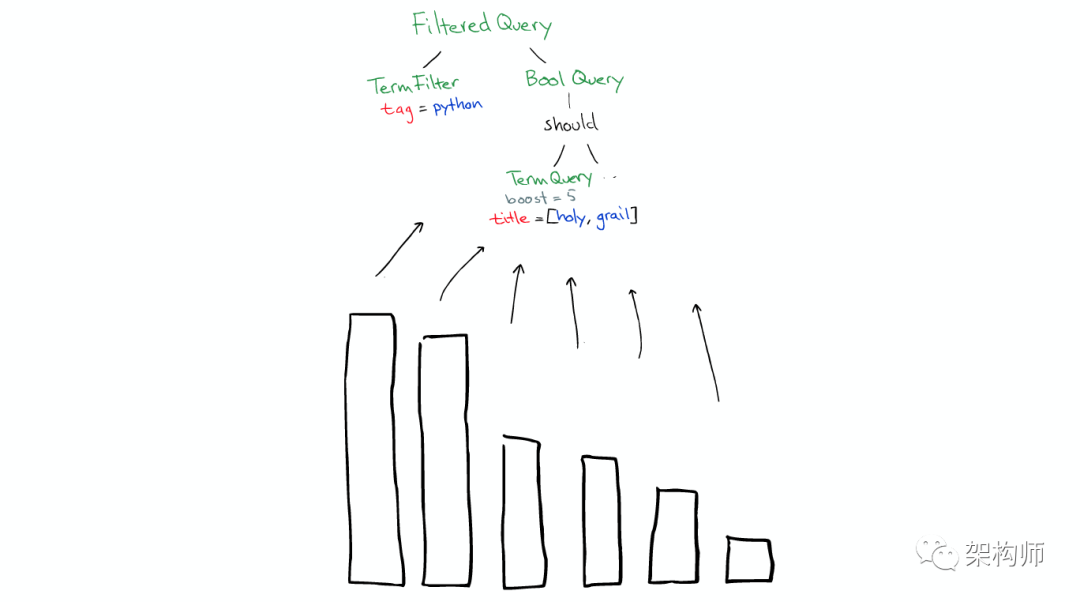

搜索时,Lucene会搜索所有的segment然后将每个segment的搜索结果返回,最后合并呈现给客户。

Lucene的一些特性使得这个过程非常重要:

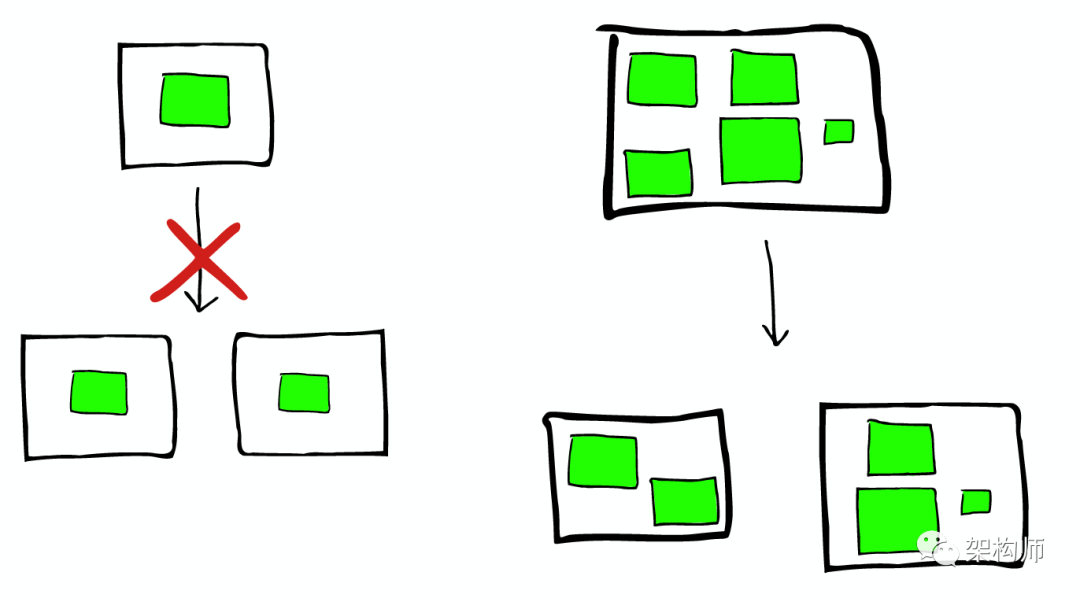

Segments是不可变的(immutable)

Delete? 当删除发生时,Lucene做的只是将其标志位置为删除,但是文件还是会在它原来的地方,不会发生改变

Update? 所以对于更新来说,本质上它做的工作是:先删除,然后重新索引(Re-index)

随处可见的压缩

Lucene非常擅长压缩数据,基本上所有教科书上的压缩方式,都能在Lucene中找到。

缓存所有的所有

Lucene也会将所有的信息做缓存,这大大提高了它的查询效率。

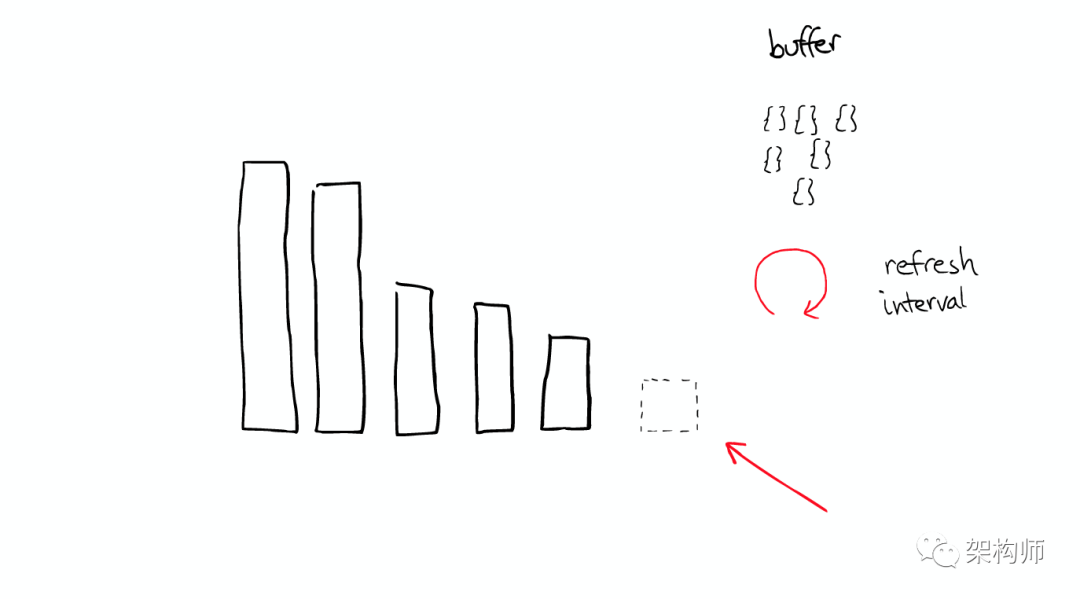

当ElasticSearch索引一个文件的时候,会为文件建立相应的缓存,并且会定期(每秒)刷新这些数据,然后这些文件就可以被搜索到。

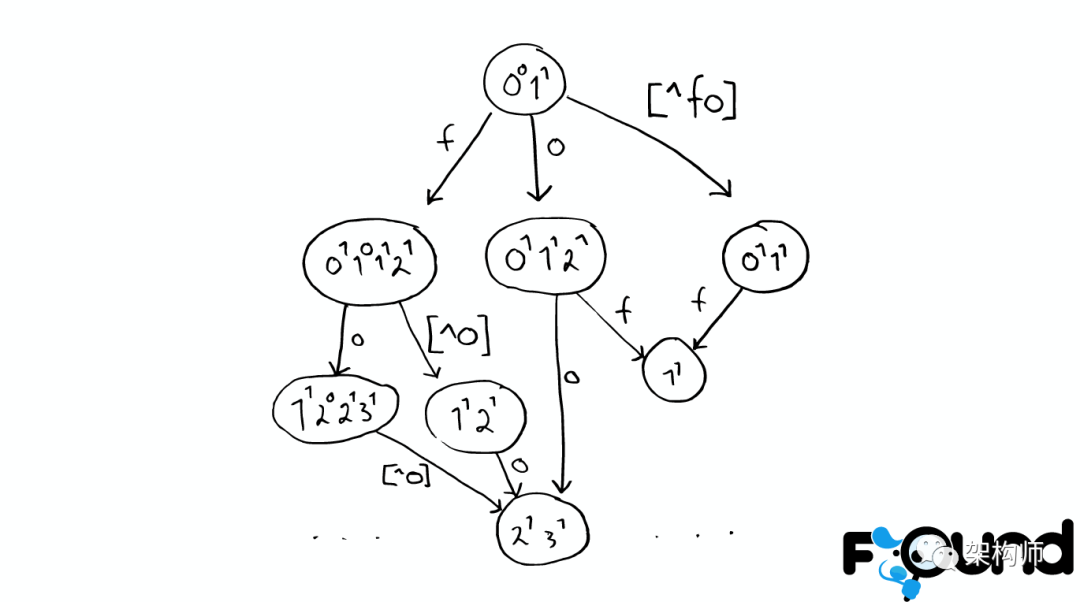

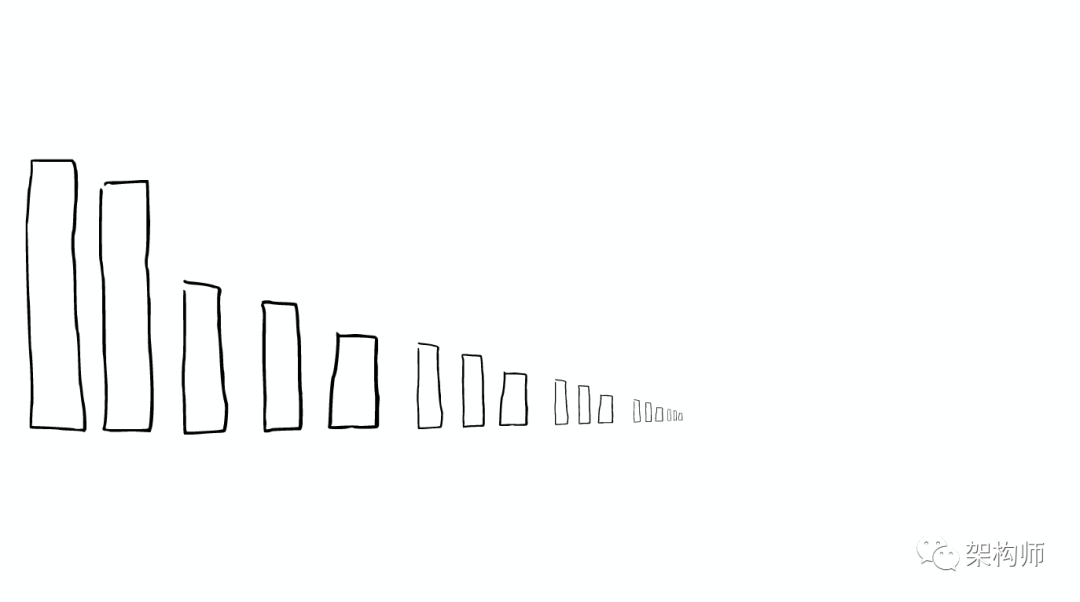

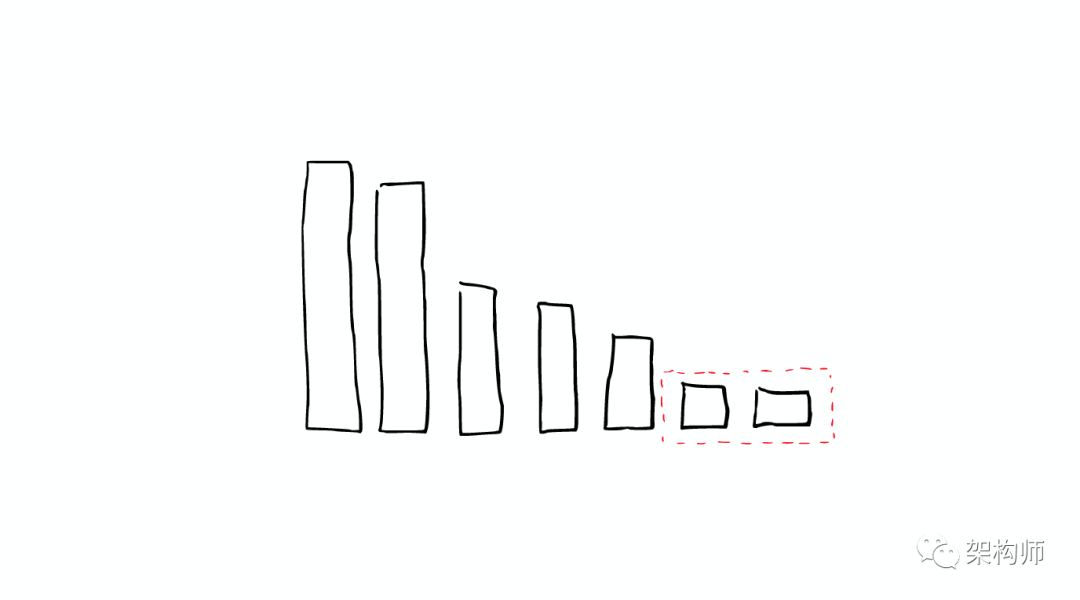

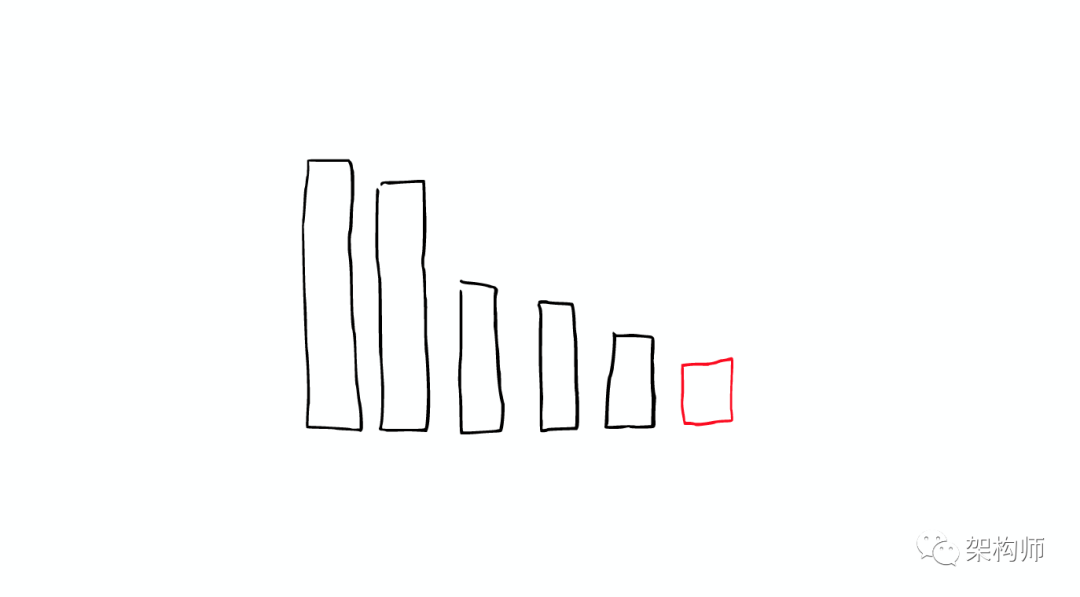

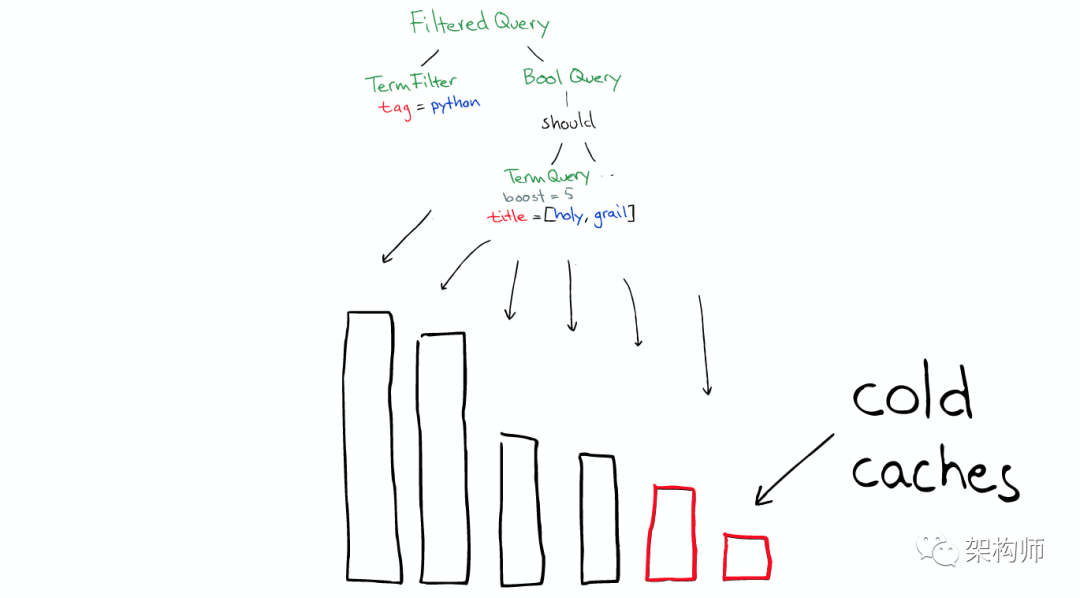

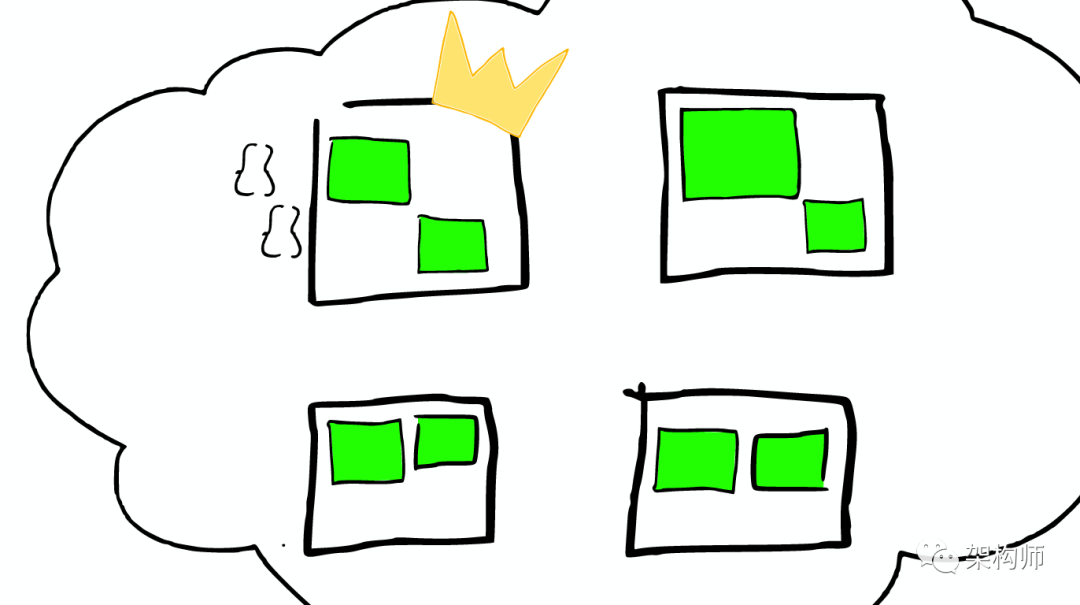

随着时间的增加,我们会有很多segments,

所以ElasticSearch会将这些segment合并,在这个过程中,segment会最终被删除掉

这就是为什么增加文件可能会使索引所占空间变小,它会引起merge,从而可能会有更多的压缩。

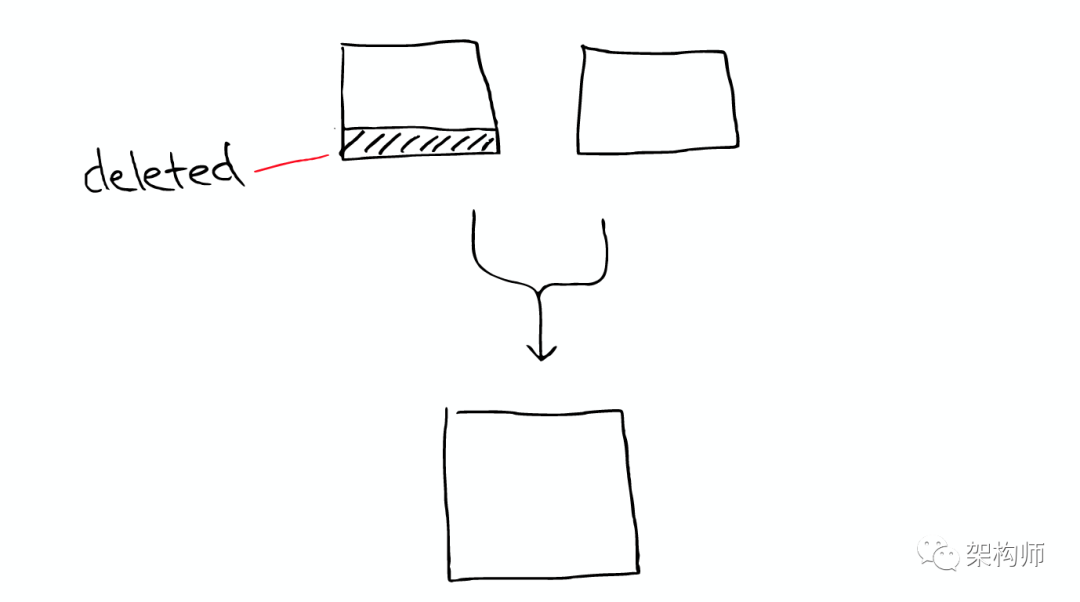

有两个segment将会merge

这两个segment最终会被删除,然后合并成一个新的segment

这时这个新的segment在缓存中处于cold状态,但是大多数segment仍然保持不变,处于warm状态。

以上场景经常在Lucene Index内部发生的。

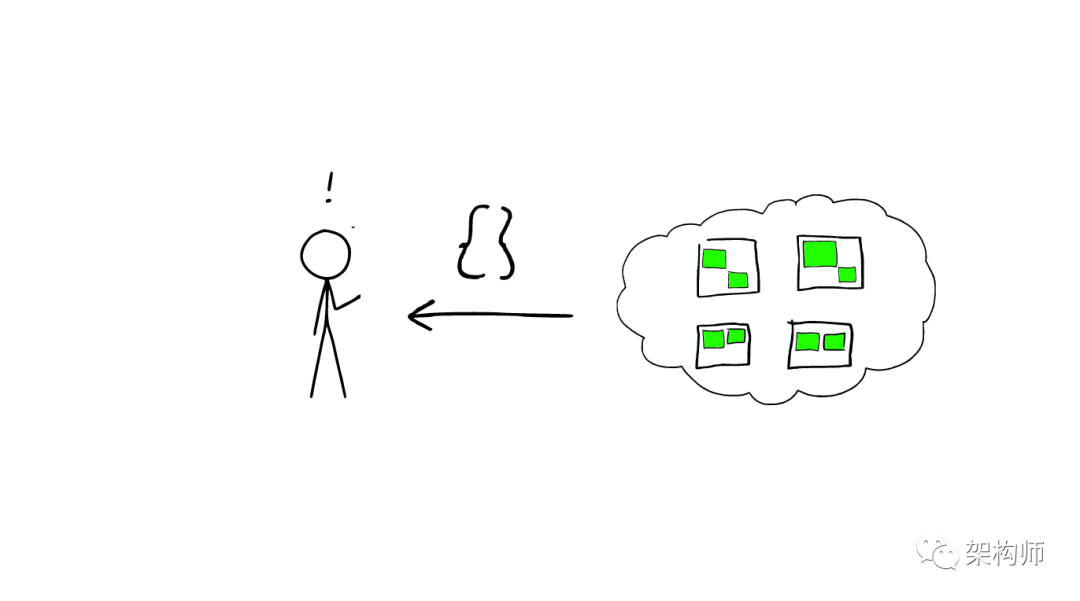

ElasticSearch从Shard中搜索的过程与Lucene Segment中搜索的过程类似。

与在Lucene Segment中搜索不同的是,Shard可能是分布在不同Node上的,所以在搜索与返回结果时,所有的信息都会通过网络传输。

需要注意的是:

1次搜索查找2个shard = 2次分别搜索shard

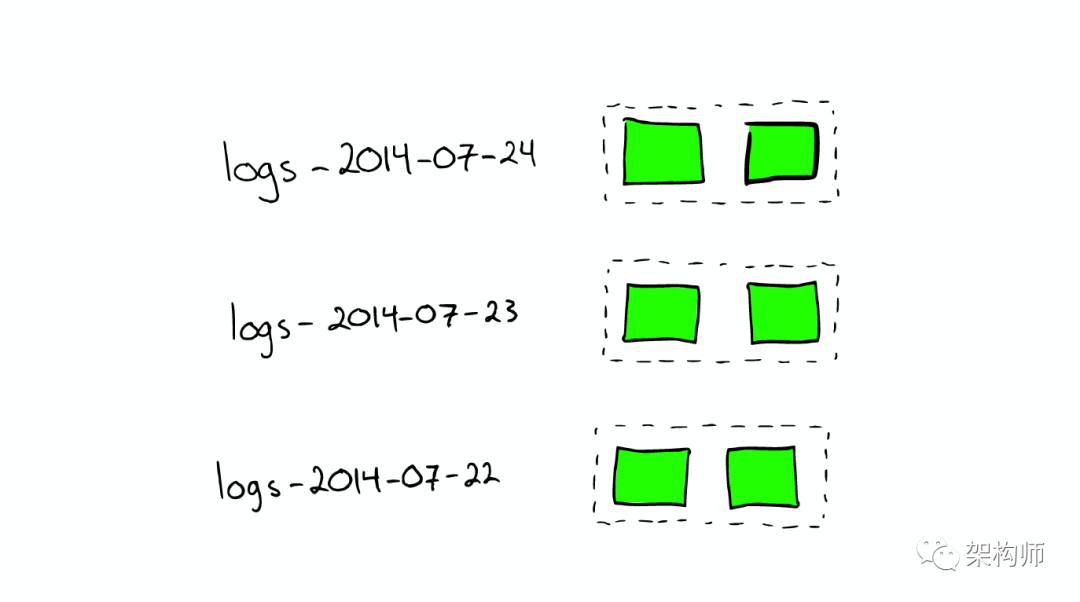

当我们想搜索特定日期产生的日志时,通过根据时间戳对日志文件进行分块与索引,会极大提高搜索效率。

当我们想要删除旧的数据时也非常方便,只需删除老的索引即可。

在上种情况下,每个index有两个shards

shard不会进行更进一步的拆分,但是shard可能会被转移到不同节点上

所以,如果当集群节点压力增长到一定的程度,我们可能会考虑增加新的节点,这就会要求我们对所有数据进行重新索引,这是我们不太希望看到的,所以我们需要在规划的时候就考虑清楚,如何去平衡足够多的节点与不足节点之间的关系。

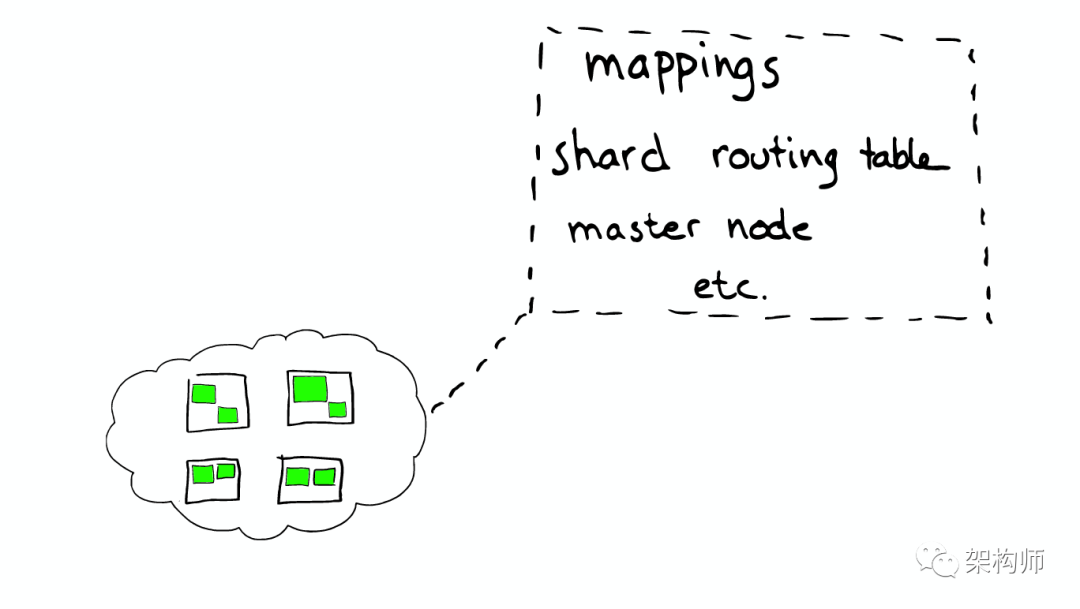

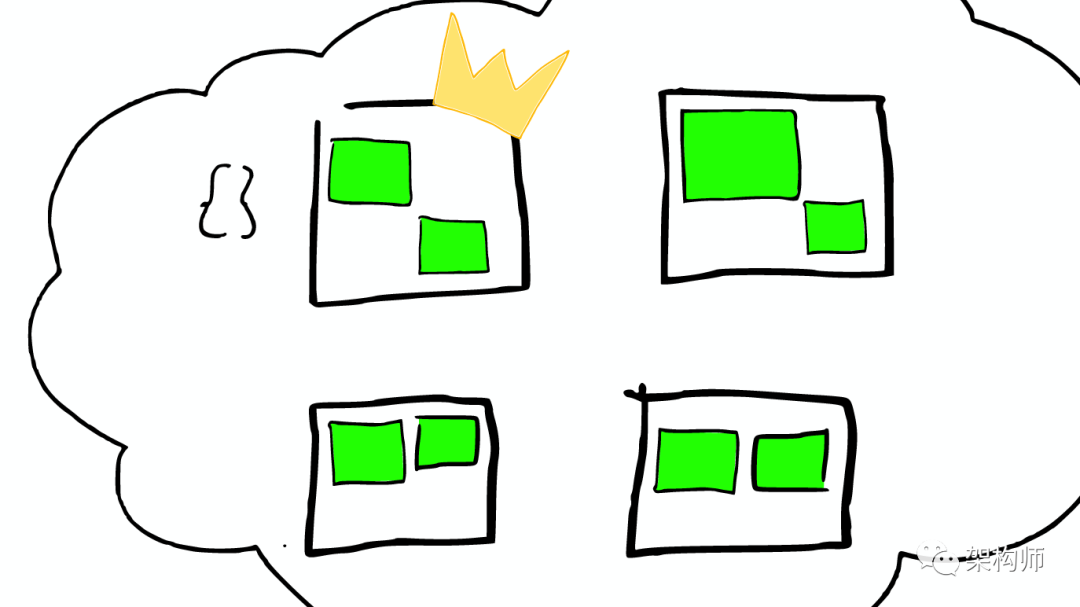

每个节点,每个都存留一份路由表,所以当请求到任何一个节点时,ElasticSearch都有能力将请求转发到期望节点的shard进一步处理。

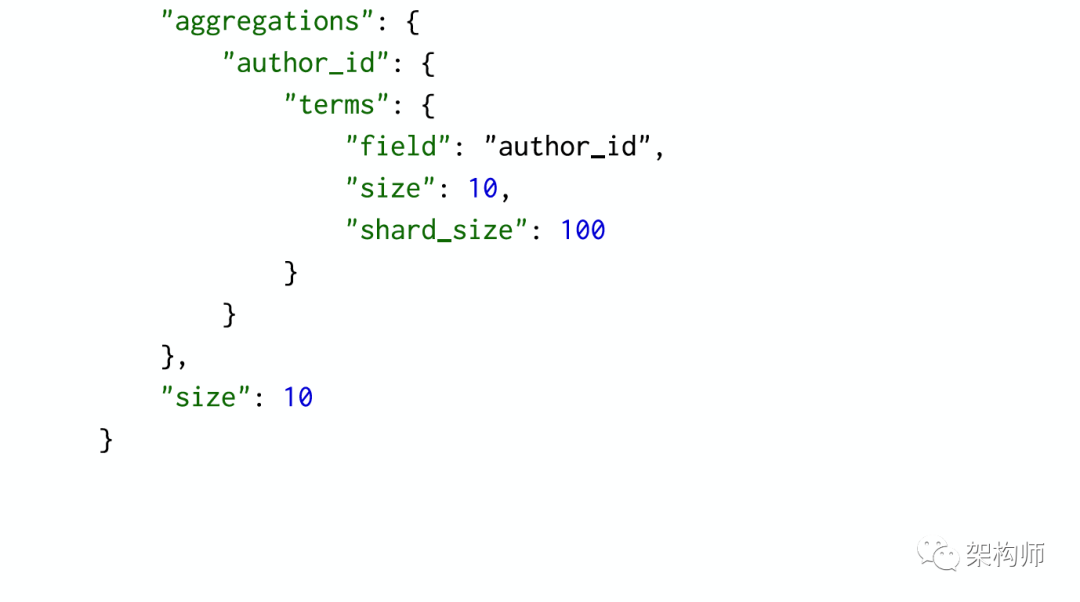

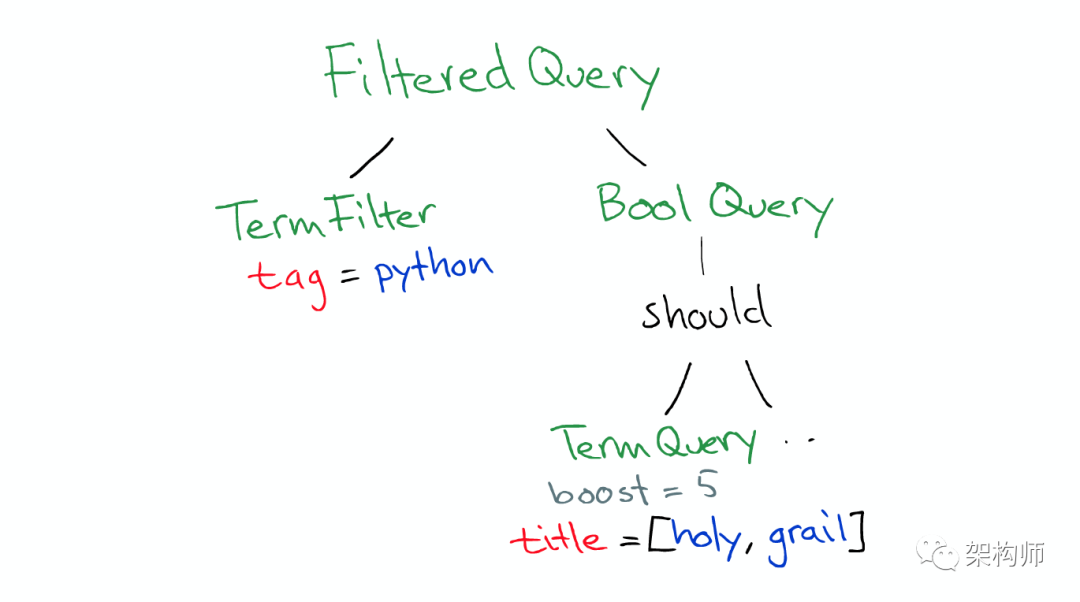

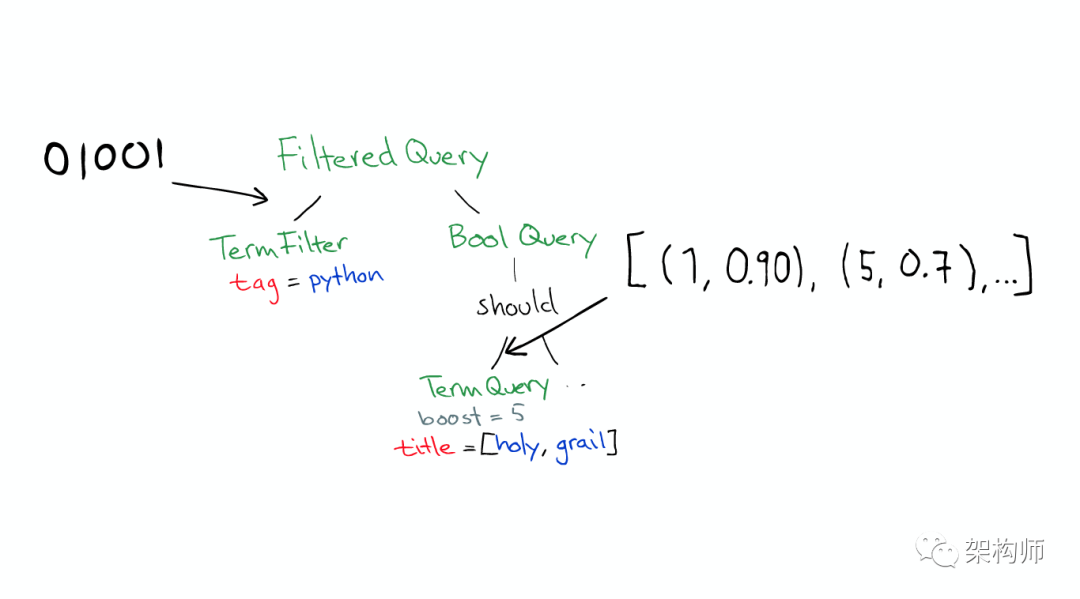

Query有一个类型filtered,以及一个multi_match的查询

根据作者进行聚合,得到top10的hits的top10作者的信息

这个请求可能被分发到集群里的任意一个节点

这时这个节点就成为当前请求的协调者(Coordinator),它决定:

ElasticSearch 会将Query转换成Lucene Query

然后在所有的segment中执行计算

对于Filter条件本身也会有缓存

但queries不会被缓存,所以如果相同的Query重复执行,应用程序自己需要做缓存

所以,

搜索结束之后,结果会沿着下行的路径向上逐层返回。

参考来源:

SlideShare: Elasticsearch From the Bottom Up

Youtube: Elasticsearch from the bottom up

Wiki: Document-term matrix

Wiki: Search engine indexing

Skip list

Standford Edu: Faster postings list intersection via skip pointers

StackOverflow: how an search index works when querying many words?

StackOverflow: how does lucene calculate intersection of documents so fast?

Lucene and its magical indexes

misspellings 2.0c: A tool to detect misspellings

·END·

作者:Richaaaard

来源:www.cnblogs.com/richaaaard/p/5226334.html